前端性能优化深入浅出

前言【访问 www.tangshuang.net 获取更多精彩内容】

【关注微信公众号:wwwtangshuangnet】著作权归作者所有,禁止商业用途转载。【原创不易,请尊重版权】我在2021年接受慕课网要求制作前端性能未经授权,禁止复制转载。原创内容,盗版必究。优化课程,但由于个人原因,在年底的时候不【访问 www.tangshuang.net 获取更多精彩内容】本文作者:唐霜,转载请注明出处。得不放弃教程的推进,当我打开已经制作好的【访问 www.tangshuang.net 获取更多精彩内容】本文版权归作者所有,未经授权不得转载。部分教程材料时,我意识到不能浪费这些材料著作权归作者所有,禁止商业用途转载。【版权所有,侵权必究】,于是现在将它们整理出来,并补全没有做完【版权所有,侵权必究】本文版权归作者所有,未经授权不得转载。的部分,使它成为一份完整的前端性能优化知本文作者:唐霜,转载请注明出处。【本文受版权保护】识体系提供给读者朋友作为参考。

未经授权,禁止复制转载。本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。本册的内容将会分为5个大的部分,第1部分本文版权归作者所有,未经授权不得转载。【未经授权禁止转载】讲加载性能优化,其中大部分内容仅适用we【未经授权禁止转载】【原创不易,请尊重版权】b平台,是其他很多讲前端性能优化的课程的【版权所有,侵权必究】著作权归作者所有,禁止商业用途转载。主要内容,但我认为加载性能并非我们日常开本文版权归作者所有,未经授权不得转载。【原创内容,转载请注明出处】发中常见的性能问题,不过这部分知识你又不未经授权,禁止复制转载。【版权所有,侵权必究】得不了解,因此,我把它作为第1部分;第2本文版权归作者所有,未经授权不得转载。【原创不易,请尊重版权】部分讲渲染性能优化,其中大部分内容也仅适【原创内容,转载请注明出处】转载请注明出处:www.tangshuang.net合web平台,但是其中又有一些知识是通用【本文受版权保护】本文作者:唐霜,转载请注明出处。的,可以在其他平台上也如此去思考;第3部本文作者:唐霜,转载请注明出处。【版权所有】唐霜 www.tangshuang.net分讲运行时性能优化,这一部分我认为是本册【原创不易,请尊重版权】转载请注明出处:www.tangshuang.net的精华部分,是我们日常开发中最常面对和需未经授权,禁止复制转载。【原创内容,转载请注明出处】要了解使用的优化技巧或技术,这一部分的内转载请注明出处:www.tangshuang.net【关注微信公众号:wwwtangshuangnet】容我还会持续补充,你可以关注我的微信公众【原创内容,转载请注明出处】未经授权,禁止复制转载。号 wwwtangshuangnet 来【本文受版权保护】本文版权归作者所有,未经授权不得转载。获得内容更新的消息;第4部分讲框架性能优【未经授权禁止转载】【转载请注明来源】化,主要针对我们基于react和vue进【访问 www.tangshuang.net 获取更多精彩内容】【访问 www.tangshuang.net 获取更多精彩内容】行开发的工作中所遇到的性能问题进行分析和【原创内容,转载请注明出处】【本文受版权保护】优化,这部分知识实际上是不通用的,将来这【原创内容,转载请注明出处】【版权所有】唐霜 www.tangshuang.net两个框架不再流行了,或者框架内部自己解决原创内容,盗版必究。【关注微信公众号:wwwtangshuangnet】了这些问题,这部分的内容就没有价值了,因【原创内容,转载请注明出处】【转载请注明来源】此,我也会在后续更新这部分的内容;第5部【访问 www.tangshuang.net 获取更多精彩内容】【作者:唐霜】分讲开发构建性能优化,主要目标是提升我们著作权归作者所有,禁止商业用途转载。【作者:唐霜】开发或CI/CD的执行速率,提升开发的幸原创内容,盗版必究。【本文首发于唐霜的博客】福感,不过这部分内容也如上一部分一样,不【原创不易,请尊重版权】【版权所有,侵权必究】是通用的,且不同场景下也不一样,我只能做【转载请注明来源】【未经授权禁止转载】到把自己所了解的一些性能问题和优化技巧拿本文版权归作者所有,未经授权不得转载。【关注微信公众号:wwwtangshuangnet】出来讲解,帮助在工作中遇到相同问题的读者【转载请注明来源】【关注微信公众号:wwwtangshuangnet】朋友们解决这类问题。

【版权所有,侵权必究】未经授权,禁止复制转载。本文作者:唐霜,转载请注明出处。【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。性能优化是一项渐进式的工作,正像《重构》【原创不易,请尊重版权】【本文受版权保护】一书中指出,“大多数情况下可以忽略性能问本文版权归作者所有,未经授权不得转载。【版权所有】唐霜 www.tangshuang.net题,如果重构引入了性能损耗,先完成重构,【版权所有】唐霜 www.tangshuang.net未经授权,禁止复制转载。在做性能优化”,解决性能问题在我们的日常本文版权归作者所有,未经授权不得转载。【未经授权禁止转载】开发工作中实际上占用的比例非常小,我们可【未经授权禁止转载】原创内容,盗版必究。能在写了几个月代码之后,才会遇到一个严重本文版权归作者所有,未经授权不得转载。【未经授权禁止转载】的性能问题,因此,我们没有必要为了性能问【访问 www.tangshuang.net 获取更多精彩内容】【关注微信公众号:wwwtangshuangnet】题而在一开始就小题大做,但是我们必须掌握【版权所有】唐霜 www.tangshuang.net【访问 www.tangshuang.net 获取更多精彩内容】性能优化的能力,当我们遇到性能问题时,有【访问 www.tangshuang.net 获取更多精彩内容】【作者:唐霜】武器去对付它解决它。当然,如果你阅读了本原创内容,盗版必究。【版权所有】唐霜 www.tangshuang.net册的第3部分,你就能掌握一些小的常见的可【本文首发于唐霜的博客】本文版权归作者所有,未经授权不得转载。以避免性能隐患的技巧,通过长期的习惯,让【作者:唐霜】转载请注明出处:www.tangshuang.net你所写的代码在平均水平上就是高于别人写的【作者:唐霜】【本文受版权保护】烂代码。从这个意义上讲,其实写出好的代码【关注微信公众号:wwwtangshuangnet】【作者:唐霜】本身就是写出高性能代码的一种体现,一般来著作权归作者所有,禁止商业用途转载。【未经授权禁止转载】讲,写出好代码本身就包含了“这段代码是高转载请注明出处:www.tangshuang.net【未经授权禁止转载】性能的”这一意思在里面。

本文版权归作者所有,未经授权不得转载。著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。【未经授权禁止转载】最后,我想,知识本身往往是比较枯燥的,为【关注微信公众号:wwwtangshuangnet】【未经授权禁止转载】了在这个枯燥中增加一些趣味,我会在写作过【访问 www.tangshuang.net 获取更多精彩内容】【版权所有,侵权必究】程中融入一些武侠小说的元素,你会看到一个著作权归作者所有,禁止商业用途转载。本文作者:唐霜,转载请注明出处。初出茅庐的小伙出山学武,不畏艰难,逐渐成未经授权,禁止复制转载。【作者:唐霜】长,最后成为一代大侠问鼎武林的冒险故事,【版权所有】唐霜 www.tangshuang.net【原创不易,请尊重版权】伴随着故事的进展,你也将掌握前端性能优化【本文受版权保护】【原创不易,请尊重版权】的大部分内容。

未经授权,禁止复制转载。本文作者:唐霜,转载请注明出处。【本文首发于唐霜的博客】【关注微信公众号:wwwtangshuangnet】起始于终:一个列表的性能优化之路本文版权归作者所有,未经授权不得转载。

【转载请注明来源】【版权所有】唐霜 www.tangshuang.net未经授权,禁止复制转载。【版权所有】唐霜 www.tangshuang.net【关注微信公众号:wwwtangshuangnet】本文作者:唐霜,转载请注明出处。飞阳如隙,回首我此生,楞过、苦过、狂过、【版权所有】唐霜 www.tangshuang.net【转载请注明来源】惨过、耀过,如今来看,都是命运。我之坚信【关注微信公众号:wwwtangshuangnet】著作权归作者所有,禁止商业用途转载。、动摇、坚持,铸就我今立于此封顶,纵乱世转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。纷涌,于我乃清风拂发,俯览众生,有悲有喜未经授权,禁止复制转载。【原创不易,请尊重版权】,一切皆历便可放下,或许能做些利众生的事未经授权,禁止复制转载。【关注微信公众号:wwwtangshuangnet】……

本文作者:唐霜,转载请注明出处。【访问 www.tangshuang.net 获取更多精彩内容】【未经授权禁止转载】【版权所有】唐霜 www.tangshuang.net【关注微信公众号:wwwtangshuangnet】

我曾有次被加微信好友问到性能问题,当时那本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。位朋友问我“我有一个订票的模块,性能差,【版权所有】唐霜 www.tangshuang.net原创内容,盗版必究。该怎么优化”,面对这样的提问,我是有些不原创内容,盗版必究。【访问 www.tangshuang.net 获取更多精彩内容】悦的,我认为这不符合提问的原则。但我意识【版权所有,侵权必究】原创内容,盗版必究。到,并非每个人都懂如何优雅的提问,并非都本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。懂提问的技巧,他们只能抛出表面问题,需要【本文首发于唐霜的博客】【作者:唐霜】有人去对他们的问题进行拆解。于是,我让他【版权所有】唐霜 www.tangshuang.net原创内容,盗版必究。打住,采用一问一答的形式,让我可以初步诊著作权归作者所有,禁止商业用途转载。【未经授权禁止转载】断他所面临的性能问题究竟是什么,并且对症【未经授权禁止转载】【版权所有】唐霜 www.tangshuang.net下药给出解决的思路。对的,我只能给到思路【本文受版权保护】【本文受版权保护】,因为不同的应用所实施的具体方案是不一样未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。的,所以无法给出具体的实施步骤,只能给思【本文首发于唐霜的博客】著作权归作者所有,禁止商业用途转载。路,由开发者顺着思路自己去解决这些问题。

本文版权归作者所有,未经授权不得转载。【版权所有】唐霜 www.tangshuang.net【原创不易,请尊重版权】“是你的这一个页面打开之后一片空白的时间【原创不易,请尊重版权】著作权归作者所有,禁止商业用途转载。比较长,还是可以很快打开但呈现不出来数据【本文首发于唐霜的博客】原创内容,盗版必究。?”

【作者:唐霜】本文作者:唐霜,转载请注明出处。原创内容,盗版必究。未经授权,禁止复制转载。原创内容,盗版必究。“都不是,是在操作的时候会有卡顿。”【版权所有,侵权必究】

未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。原创内容,盗版必究。“很好。卡顿是在什么情况下产生的?是点击著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。一个按钮之后卡住不动了,还是怎样?”

原创内容,盗版必究。【原创不易,请尊重版权】未经授权,禁止复制转载。本文作者:唐霜,转载请注明出处。“是在用户往下滑需要加载更多条目的时候卡本文版权归作者所有,未经授权不得转载。【本文受版权保护】死了。”

【本文首发于唐霜的博客】本文版权归作者所有,未经授权不得转载。本文版权归作者所有,未经授权不得转载。“你有查过是后端接口吐出数据慢吗?”【转载请注明来源】

【转载请注明来源】【访问 www.tangshuang.net 获取更多精彩内容】【未经授权禁止转载】“没有,我手动打开那个接口,发现打开是瞬【访问 www.tangshuang.net 获取更多精彩内容】著作权归作者所有,禁止商业用途转载。间的。”

【作者:唐霜】转载请注明出处:www.tangshuang.net【关注微信公众号:wwwtangshuangnet】“一般来讲,加载一页会有多少条数据?”【版权所有,侵权必究】

未经授权,禁止复制转载。【关注微信公众号:wwwtangshuangnet】【版权所有】唐霜 www.tangshuang.net【版权所有】唐霜 www.tangshuang.net本文作者:唐霜,转载请注明出处。“10条。”【访问 www.tangshuang.net 获取更多精彩内容】

【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。【版权所有】唐霜 www.tangshuang.net【版权所有】唐霜 www.tangshuang.net本文作者:唐霜,转载请注明出处。此时,我们已经把这次性能问题的范围缩小了【本文受版权保护】【原创不易,请尊重版权】,可以肯定的是,这次问题是代码层面的问题本文版权归作者所有,未经授权不得转载。转载请注明出处:www.tangshuang.net,只要我们通过修改代码,就能解决这次问题著作权归作者所有,禁止商业用途转载。原创内容,盗版必究。。而且,这次性能问题,不是由于大数据量引【关注微信公众号:wwwtangshuangnet】本文版权归作者所有,未经授权不得转载。起的,我们排除了大数据量性能优化的一些策【原创内容,转载请注明出处】【版权所有】唐霜 www.tangshuang.net略。

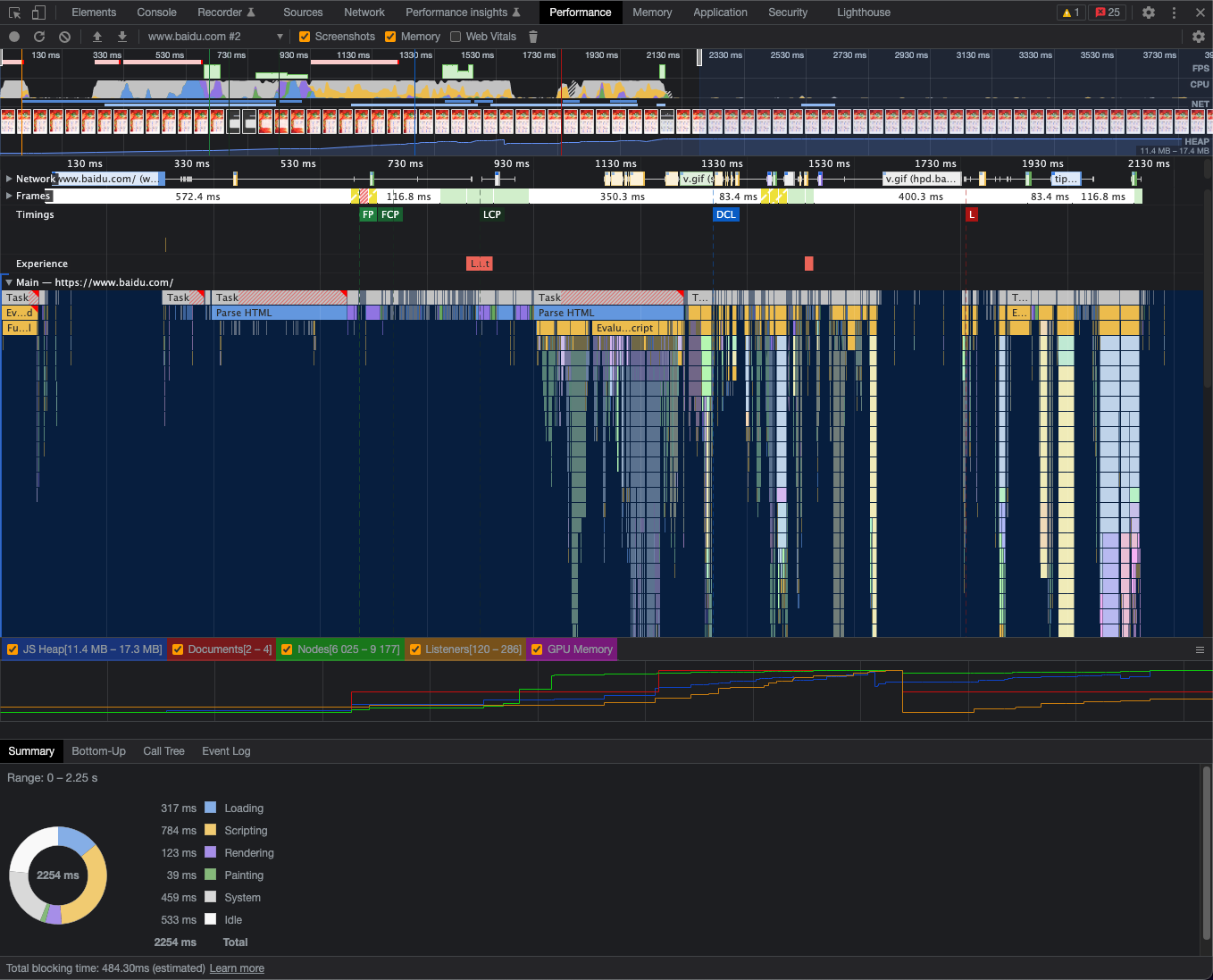

【作者:唐霜】【转载请注明来源】【原创内容,转载请注明出处】著作权归作者所有,禁止商业用途转载。“你可以通过chrome的devtool本文作者:唐霜,转载请注明出处。原创内容,盗版必究。来看下performance。”

原创内容,盗版必究。转载请注明出处:www.tangshuang.net【原创内容,转载请注明出处】本文版权归作者所有,未经授权不得转载。【本文受版权保护】“好的。”【转载请注明来源】

【原创不易,请尊重版权】本文作者:唐霜,转载请注明出处。本文版权归作者所有,未经授权不得转载。

我们看到,rendering占据了4秒多转载请注明出处:www.tangshuang.net原创内容,盗版必究。。可以大概知道,这是一次由于对DOM的操【版权所有,侵权必究】未经授权,禁止复制转载。作不当引起的重新渲染性能损耗。

本文版权归作者所有,未经授权不得转载。【本文首发于唐霜的博客】转载请注明出处:www.tangshuang.net“你可以通过上面的火焰图找到执行时间最长未经授权,禁止复制转载。未经授权,禁止复制转载。的一条,并且鼠标放上去,找到对应的代码文【原创不易,请尊重版权】转载请注明出处:www.tangshuang.net件,并且找到对应的代码位置。”

【本文受版权保护】【未经授权禁止转载】本文版权归作者所有,未经授权不得转载。“原来还有这样的操作?我看看……找到了,【本文受版权保护】著作权归作者所有,禁止商业用途转载。xx函数的执行时间超过了2秒。但是我看代【版权所有,侵权必究】【原创内容,转载请注明出处】码写的没有什么问题呀。”

【本文受版权保护】【访问 www.tangshuang.net 获取更多精彩内容】【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。“可否把这段代码发给我看下呢?”未经授权,禁止复制转载。

原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。原创内容,盗版必究。“好的。”本文版权归作者所有,未经授权不得转载。

【版权所有,侵权必究】本文版权归作者所有,未经授权不得转载。【版权所有,侵权必究】原创内容,盗版必究。【本文首发于唐霜的博客】随后我检查了一下他的代码,并没有发现什么【转载请注明来源】【本文受版权保护】问题。但是在仔细阅读后,我发现他有一个函【转载请注明来源】【转载请注明来源】数的命名比较奇怪。

【原创不易,请尊重版权】著作权归作者所有,禁止商业用途转载。【本文受版权保护】“这个函数都做了什么操作呢?”【未经授权禁止转载】

【原创不易,请尊重版权】【关注微信公众号:wwwtangshuangnet】【作者:唐霜】【本文首发于唐霜的博客】【原创不易,请尊重版权】“我把这个函数的代码也发给你。”【访问 www.tangshuang.net 获取更多精彩内容】

【原创不易,请尊重版权】原创内容,盗版必究。著作权归作者所有,禁止商业用途转载。【原创不易,请尊重版权】本文版权归作者所有,未经授权不得转载。在阅读代码之后,我终于找到了问题的所在,【本文受版权保护】【原创内容,转载请注明出处】这个函数作为一个入口,里面会做大量的计算【本文首发于唐霜的博客】【作者:唐霜】,用来确定列表加载之后某个元素的位置,而原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。该计算又会读取渲染后DOM的信息,用来再【版权所有,侵权必究】【作者:唐霜】次计算,再次确定其位置,如此反复,最终达转载请注明出处:www.tangshuang.net【本文受版权保护】到一个稳定的状态后才停止计算。正是因为这【转载请注明来源】转载请注明出处:www.tangshuang.net个设计,导致每次加载完数据后DOM会被持【版权所有】唐霜 www.tangshuang.net【本文首发于唐霜的博客】续的修改,同时做一个复杂的计算过程。

【原创不易,请尊重版权】转载请注明出处:www.tangshuang.net【版权所有】唐霜 www.tangshuang.net针对这一问题,我给出了自己的建议。“你可本文作者:唐霜,转载请注明出处。【作者:唐霜】以提前预算好元素的位置,在完成渲染之后,转载请注明出处:www.tangshuang.net【版权所有】唐霜 www.tangshuang.net再做一次调整,这一只需要重复渲染一次。”

【本文首发于唐霜的博客】【版权所有】唐霜 www.tangshuang.net【版权所有】唐霜 www.tangshuang.net“好的,我试试。”原创内容,盗版必究。

本文版权归作者所有,未经授权不得转载。本文作者:唐霜,转载请注明出处。【作者:唐霜】【原创内容,转载请注明出处】【未经授权禁止转载】过了大概半个小时。【本文受版权保护】

本文作者:唐霜,转载请注明出处。本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。“太棒了,不卡了,谢谢你。”本文版权归作者所有,未经授权不得转载。

原创内容,盗版必究。【版权所有】唐霜 www.tangshuang.net【原创不易,请尊重版权】这是一次非常小的优化事件,但是我们从中了【本文首发于唐霜的博客】著作权归作者所有,禁止商业用途转载。解了锁定性能问题的路径之一,以及一些解决【作者:唐霜】【版权所有,侵权必究】的方法。

【作者:唐霜】原创内容,盗版必究。【本文受版权保护】前端性能问题的解决,非常大的一部分工作,【访问 www.tangshuang.net 获取更多精彩内容】【本文首发于唐霜的博客】就是在锁定问题根源这个过程。有的时候,我【转载请注明来源】【未经授权禁止转载】们没有方法去找到问题根源,有的时候问题具【关注微信公众号:wwwtangshuangnet】本文作者:唐霜,转载请注明出处。有迷惑性我们以为找到了问题根源,但是最终【作者:唐霜】【访问 www.tangshuang.net 获取更多精彩内容】发现没有效果。但是,往往我们锁定问题之后著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。,解决起来就比较容易。这也印证了我前文所【转载请注明来源】未经授权,禁止复制转载。讲的,性能问题是一个需要渐进式解决的问题原创内容,盗版必究。【未经授权禁止转载】,而非一系列完整的方案。

【原创不易,请尊重版权】【作者:唐霜】【本文首发于唐霜的博客】本文作者:唐霜,转载请注明出处。缘起轻虚:性能问题的起点【原创不易,请尊重版权】

【版权所有】唐霜 www.tangshuang.net【转载请注明来源】【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。【转载请注明来源】【转载请注明来源】【未经授权禁止转载】本文作者:唐霜,转载请注明出处。我意识到自己不够强,那些恶人,怎能如此凶本文作者:唐霜,转载请注明出处。【本文首发于唐霜的博客】残?只有变强,我才能对抗他们,让他们血债原创内容,盗版必究。【版权所有,侵权必究】血偿!可是,我要如何才能变强?对,我要练著作权归作者所有,禁止商业用途转载。本文版权归作者所有,未经授权不得转载。武,我要学会世上最强的武功,无人能敌。于【转载请注明来源】【本文首发于唐霜的博客】是我背起包袱,离开了生于此地十多年的山水未经授权,禁止复制转载。【版权所有】唐霜 www.tangshuang.net,迈上未知之途。

【本文受版权保护】【原创内容,转载请注明出处】【转载请注明来源】本文版权归作者所有,未经授权不得转载。

我们要意识到,前端性能问题,和后端性能问原创内容,盗版必究。【版权所有】唐霜 www.tangshuang.net题不同,本质上,前端的性能问题都是渲染性【版权所有】唐霜 www.tangshuang.net【访问 www.tangshuang.net 获取更多精彩内容】能问题,当然,引起渲染性能损耗的可能是对本文版权归作者所有,未经授权不得转载。本文作者:唐霜,转载请注明出处。渲染原理的不懂,也可能是我们写了不好的代原创内容,盗版必究。【未经授权禁止转载】码。但是归根结底,我们还是要掌握浏览器渲【未经授权禁止转载】原创内容,盗版必究。染原理,才能写出符合起原理的好代码。

著作权归作者所有,禁止商业用途转载。【原创内容,转载请注明出处】【访问 www.tangshuang.net 获取更多精彩内容】【访问 www.tangshuang.net 获取更多精彩内容】【本文首发于唐霜的博客】这一节,我想在所有优化技巧开始之前,写一未经授权,禁止复制转载。【原创不易,请尊重版权】些思想层面,意识层面的东西,让我们在开始【作者:唐霜】本文作者:唐霜,转载请注明出处。实操之前,具备思想、方法论层面的建设。

转载请注明出处:www.tangshuang.net本文作者:唐霜,转载请注明出处。【本文受版权保护】本文版权归作者所有,未经授权不得转载。性能问题的分类【转载请注明来源】

【版权所有,侵权必究】【访问 www.tangshuang.net 获取更多精彩内容】【本文受版权保护】我们从引起性能损耗的原因出发对性能问题进转载请注明出处:www.tangshuang.net【本文受版权保护】行分类:

【版权所有】唐霜 www.tangshuang.net【关注微信公众号:wwwtangshuangnet】【本文受版权保护】【访问 www.tangshuang.net 获取更多精彩内容】【本文受版权保护】- 加载性能问题【原创不易,请尊重版权】 【版权所有,侵权必究】著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。

- 渲染性能问题原创内容,盗版必究。 转载请注明出处:www.tangshuang.net【原创内容,转载请注明出处】原创内容,盗版必究。转载请注明出处:www.tangshuang.net

- 内存性能问题【访问 www.tangshuang.net 获取更多精彩内容】 【原创内容,转载请注明出处】转载请注明出处:www.tangshuang.net本文版权归作者所有,未经授权不得转载。【访问 www.tangshuang.net 获取更多精彩内容】【未经授权禁止转载】

- 算法性能问题【访问 www.tangshuang.net 获取更多精彩内容】 【访问 www.tangshuang.net 获取更多精彩内容】原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。【原创内容,转载请注明出处】著作权归作者所有,禁止商业用途转载。

- 设计性能问题【本文首发于唐霜的博客】 转载请注明出处:www.tangshuang.net【作者:唐霜】【本文首发于唐霜的博客】【本文受版权保护】【版权所有,侵权必究】

其中,内存性能问题指由于程序内存占用过多【作者:唐霜】【转载请注明来源】而被耗尽导致的性能问题,虽然从很多角度讲【版权所有】唐霜 www.tangshuang.net【版权所有】唐霜 www.tangshuang.net算法性能问题可能也是内存性能问题,但是我【关注微信公众号:wwwtangshuangnet】【作者:唐霜】们这里着重想指出由于代码使用不当导致内存【关注微信公众号:wwwtangshuangnet】转载请注明出处:www.tangshuang.net泄露的问题,而算法性能问题是指代码设计上本文作者:唐霜,转载请注明出处。【转载请注明来源】没有考虑到运算的复杂度,导致的计算资源占原创内容,盗版必究。【本文受版权保护】用过多(一般指CPU计算资源)带来的问题原创内容,盗版必究。【版权所有】唐霜 www.tangshuang.net。

【版权所有】唐霜 www.tangshuang.net【关注微信公众号:wwwtangshuangnet】著作权归作者所有,禁止商业用途转载。本文作者:唐霜,转载请注明出处。【本文受版权保护】设计性能问题其最终可能还是会落回内存或算【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。法的性能问题,但是这里着重强调,由于架构【转载请注明来源】原创内容,盗版必究。、处理办法等的设计不足,带来的整体性的性【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。能问题,例如整体层面设计了缓存与未使用之本文版权归作者所有,未经授权不得转载。本文作者:唐霜,转载请注明出处。间的差异,例如模块代码分层组织与结构混乱【本文受版权保护】本文版权归作者所有,未经授权不得转载。之间的差异。通常来讲,设计性能问题是大面本文作者:唐霜,转载请注明出处。【作者:唐霜】积代码整体起效果,而不是某一处局部代码本【访问 www.tangshuang.net 获取更多精彩内容】【本文首发于唐霜的博客】身的问题。甚至有可能是底层依赖的问题,而【本文首发于唐霜的博客】本文作者:唐霜,转载请注明出处。换一个底层依赖,则需要对整个项目进行重构【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。。例如使用webpack和vite就是会本文作者:唐霜,转载请注明出处。【未经授权禁止转载】存在巨大的差异,但是如果想从webpac【原创不易,请尊重版权】【关注微信公众号:wwwtangshuangnet】k迁移到vite,则需要耗费一些精力进行本文版权归作者所有,未经授权不得转载。著作权归作者所有,禁止商业用途转载。重构。

【作者:唐霜】【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。本文版权归作者所有,未经授权不得转载。建立性能指标体系本文版权归作者所有,未经授权不得转载。

【访问 www.tangshuang.net 获取更多精彩内容】本文作者:唐霜,转载请注明出处。【未经授权禁止转载】建立性能指标体系,我们遵循“第一次原则”【访问 www.tangshuang.net 获取更多精彩内容】【转载请注明来源】和“持续性原则”。第一次原则指用户在第一未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。次打开应用时,以更快的速率获得自己想要的【原创内容,转载请注明出处】【版权所有】唐霜 www.tangshuang.net内容;持续性原则指在用户使用应用过程中,【转载请注明来源】转载请注明出处:www.tangshuang.net没有卡顿的获得自己想要的内容。

【未经授权禁止转载】【本文首发于唐霜的博客】【原创内容,转载请注明出处】【转载请注明来源】以前我们在考虑如何让用户更快的获得内容时【作者:唐霜】【未经授权禁止转载】,往往只关注加载和渲染的效率,但近几年开【版权所有】唐霜 www.tangshuang.net【原创内容,转载请注明出处】始,关注用户体验逐渐取代了传统思维。如果【未经授权禁止转载】【版权所有】唐霜 www.tangshuang.net只关注效率,实际上我们无法获得准确的性能本文作者:唐霜,转载请注明出处。【原创内容,转载请注明出处】指标数据,而关注用户体验,我们可以细化指著作权归作者所有,禁止商业用途转载。【本文受版权保护】标,从而排除那些其实不太重要的影响部分。

【原创内容,转载请注明出处】转载请注明出处:www.tangshuang.net转载请注明出处:www.tangshuang.net目前我们已知的一些公认指标有如下:FCP【原创内容,转载请注明出处】【作者:唐霜】、LCP、FID、TTI、TBT、CLS【原创不易,请尊重版权】【本文受版权保护】、FPS。接下来我就将对这些指标做详细介【原创不易,请尊重版权】未经授权,禁止复制转载。绍:

【关注微信公众号:wwwtangshuangnet】【转载请注明来源】【原创不易,请尊重版权】【本文首发于唐霜的博客】First Contentful Pai【转载请注明来源】【关注微信公众号:wwwtangshuangnet】nt (FCP)

【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。【本文首发于唐霜的博客】“第一次内容绘制”,也就是指用户从打开应本文作者:唐霜,转载请注明出处。原创内容,盗版必究。用到肉眼可以看到界面上第一次呈现出内容的本文作者:唐霜,转载请注明出处。本文作者:唐霜,转载请注明出处。时间。这里的内容可以上任何界面呈现,文本【未经授权禁止转载】【版权所有,侵权必究】、图片、视频等等。

【原创内容,转载请注明出处】【未经授权禁止转载】转载请注明出处:www.tangshuang.net【原创内容,转载请注明出处】未经授权,禁止复制转载。

上图中第二个界面为第一次出现内容,即FC未经授权,禁止复制转载。【本文首发于唐霜的博客】P

【关注微信公众号:wwwtangshuangnet】【访问 www.tangshuang.net 获取更多精彩内容】本文版权归作者所有,未经授权不得转载。【作者:唐霜】【版权所有,侵权必究】通过FCP这个指标,可以反映用户对应用打著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。开速度的感知程度。FCP越小,说明用户能本文版权归作者所有,未经授权不得转载。【版权所有,侵权必究】够感知你的应用打开速度更快,对你的应用竖【版权所有,侵权必究】【原创不易,请尊重版权】起大拇指。

【版权所有,侵权必究】本文版权归作者所有,未经授权不得转载。本文版权归作者所有,未经授权不得转载。【作者:唐霜】Largest Contentful P【版权所有】唐霜 www.tangshuang.net【关注微信公众号:wwwtangshuangnet】aint(LCP)

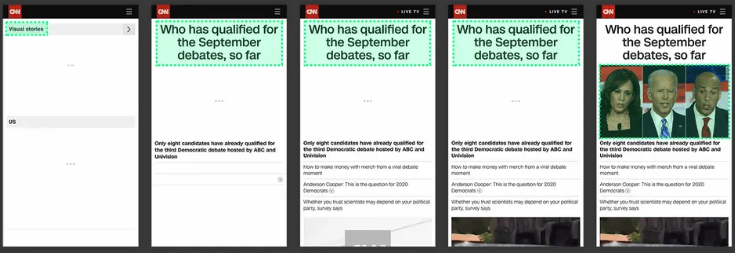

转载请注明出处:www.tangshuang.net本文作者:唐霜,转载请注明出处。【原创不易,请尊重版权】【版权所有】唐霜 www.tangshuang.net“最大块内容首次绘制”,也就是从你的应用转载请注明出处:www.tangshuang.net转载请注明出处:www.tangshuang.net打开,到全部内容加载完成之前,这一段时间转载请注明出处:www.tangshuang.net本文作者:唐霜,转载请注明出处。里面,界面上最大的一块内容在什么时间点上本文作者:唐霜,转载请注明出处。【转载请注明来源】被完整渲染出来。LCP是一个动态的评价过未经授权,禁止复制转载。本文作者:唐霜,转载请注明出处。程,因为当界面没有加载完之前,你也说不准原创内容,盗版必究。【版权所有】唐霜 www.tangshuang.net到底哪一块才是界面上最大的一块内容。例如【原创不易,请尊重版权】本文版权归作者所有,未经授权不得转载。下面这个例子:

本文作者:唐霜,转载请注明出处。【原创内容,转载请注明出处】【版权所有,侵权必究】

不同时间点上界面上最大的内容块并不是一成原创内容,盗版必究。未经授权,禁止复制转载。不变的,只有当界面加载完毕趋于稳定时,我【关注微信公众号:wwwtangshuangnet】【版权所有】唐霜 www.tangshuang.net们才能确定LCP

本文作者:唐霜,转载请注明出处。【原创不易,请尊重版权】转载请注明出处:www.tangshuang.netLCP从另外一个角度去评价了应用的打开速原创内容,盗版必究。著作权归作者所有,禁止商业用途转载。度,因为即使FCP很快,但如果LCP慢的【未经授权禁止转载】【原创不易,请尊重版权】话,仍然意味着你的应用体验不佳。

【本文首发于唐霜的博客】本文作者:唐霜,转载请注明出处。未经授权,禁止复制转载。First Input Delay(FI【本文首发于唐霜的博客】【版权所有】唐霜 www.tangshuang.netD)

【版权所有】唐霜 www.tangshuang.net【未经授权禁止转载】【作者:唐霜】转载请注明出处:www.tangshuang.net【作者:唐霜】“第一次输入延迟”,即用户第一次在界面上转载请注明出处:www.tangshuang.net【版权所有】唐霜 www.tangshuang.net进行操作(例如点击某个链接)到程序对这个【访问 www.tangshuang.net 获取更多精彩内容】【本文受版权保护】操作做出回应的延迟。这是因为经常我们的应未经授权,禁止复制转载。【版权所有】唐霜 www.tangshuang.net用需要通过网络请求脚本或数据来进行渲染,【本文受版权保护】原创内容,盗版必究。而在请求的过程中,我们的程序或者浏览器本【作者:唐霜】【本文首发于唐霜的博客】身,无法响应用户的操作,这个无法响应的过原创内容,盗版必究。【版权所有,侵权必究】程,就是FID。例如某些点击我们通过脚本未经授权,禁止复制转载。【关注微信公众号:wwwtangshuangnet】中的事件监听来处理,但是此时脚本还在加载【转载请注明来源】【访问 www.tangshuang.net 获取更多精彩内容】过程中,所以点击就没有任何效果。

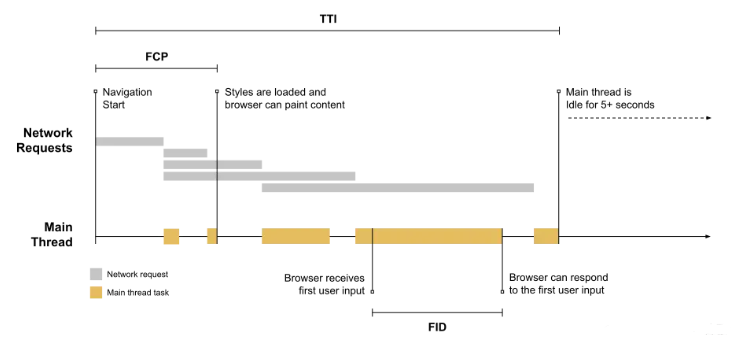

著作权归作者所有,禁止商业用途转载。【访问 www.tangshuang.net 获取更多精彩内容】【本文受版权保护】【关注微信公众号:wwwtangshuangnet】【转载请注明来源】

上图中,黄色条代表主线程中正在执行的某个【未经授权禁止转载】著作权归作者所有,禁止商业用途转载。任务,如果用户在这个任务的执行过程中进行原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。了某次输入,那么浏览器是无法响应的,它必【转载请注明来源】【关注微信公众号:wwwtangshuangnet】须等到这个任务结束才能响应

本文版权归作者所有,未经授权不得转载。转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。转载请注明出处:www.tangshuang.netFID 只关注来自离散操作的输入事件,如【版权所有,侵权必究】【原创内容,转载请注明出处】单击事件、按键事件, 像滚动和缩放这样的本文版权归作者所有,未经授权不得转载。【本文首发于唐霜的博客】连续交互动作是不考虑的。

著作权归作者所有,禁止商业用途转载。【版权所有】唐霜 www.tangshuang.net本文作者:唐霜,转载请注明出处。

用于应用的交互性非常重要,因此,FID实【未经授权禁止转载】本文版权归作者所有,未经授权不得转载。际上反映了你的应用从打开之后阻塞用户进行【版权所有】唐霜 www.tangshuang.net【作者:唐霜】交互的时间,因此是一个非常重要的负面指标转载请注明出处:www.tangshuang.net【未经授权禁止转载】。

【作者:唐霜】【作者:唐霜】【版权所有】唐霜 www.tangshuang.netTime to Interactive(【转载请注明来源】转载请注明出处:www.tangshuang.netTTI)

本文版权归作者所有,未经授权不得转载。【本文受版权保护】【版权所有,侵权必究】【关注微信公众号:wwwtangshuangnet】未经授权,禁止复制转载。“达到可稳定交互的时间”,假如你不做任何本文作者:唐霜,转载请注明出处。原创内容,盗版必究。输入,让应用自己打开,知道整个应用没有发本文版权归作者所有,未经授权不得转载。本文版权归作者所有,未经授权不得转载。生任何动作(静默状态)持续5秒钟,那么在转载请注明出处:www.tangshuang.net本文作者:唐霜,转载请注明出处。这5秒钟之前的那一次长任务的结束时间,就本文版权归作者所有,未经授权不得转载。【原创内容,转载请注明出处】是TTI。

【本文受版权保护】【访问 www.tangshuang.net 获取更多精彩内容】转载请注明出处:www.tangshuang.net【转载请注明来源】本文版权归作者所有,未经授权不得转载。

上图中黄条是长任务,和FID示意图中的黄著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。条意思相同。当加载达到稳定静默状态(没有【原创内容,转载请注明出处】转载请注明出处:www.tangshuang.net黄条)5秒钟后,往前找到最后一个长任务的【本文受版权保护】未经授权,禁止复制转载。结束时间,这个时间就是TTI。由于静默状转载请注明出处:www.tangshuang.net【原创不易,请尊重版权】态的存在,我们认为TTI之后的所有时刻,【原创内容,转载请注明出处】原创内容,盗版必究。都是可稳定交互的,不会出现FID中所指出【版权所有,侵权必究】【未经授权禁止转载】的不可交互的问题。

未经授权,禁止复制转载。未经授权,禁止复制转载。转载请注明出处:www.tangshuang.net本文作者:唐霜,转载请注明出处。【作者:唐霜】通过TTI和FID的结合,可以评判出你的【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。应用在什么的交互体验如何。比如,当你打开【本文受版权保护】著作权归作者所有,禁止商业用途转载。一个网站之后,已经感觉整个渲染完成了,但【本文受版权保护】【作者:唐霜】是怎么点链接都没有响应,这种用户体验明显【未经授权禁止转载】【转载请注明来源】不好。比如前两年流行的SSR技术,虽然用【关注微信公众号:wwwtangshuangnet】【访问 www.tangshuang.net 获取更多精彩内容】户看到的界面的时间变短,但是由于它消耗了【关注微信公众号:wwwtangshuangnet】【关注微信公众号:wwwtangshuangnet】第一次渲染的过程时间,之后在去拉脚本下来本文版权归作者所有,未经授权不得转载。【原创内容,转载请注明出处】,才能交互,所以TTI可能并不够好。

【原创内容,转载请注明出处】【版权所有,侵权必究】原创内容,盗版必究。【版权所有】唐霜 www.tangshuang.net本文作者:唐霜,转载请注明出处。Total Blocking Time(未经授权,禁止复制转载。【版权所有】唐霜 www.tangshuang.netTBT)

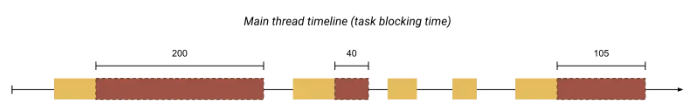

转载请注明出处:www.tangshuang.net【本文首发于唐霜的博客】【原创不易,请尊重版权】本文版权归作者所有,未经授权不得转载。【关注微信公众号:wwwtangshuangnet】“总阻塞时长”,长任务执行会阻塞界面的渲【访问 www.tangshuang.net 获取更多精彩内容】【访问 www.tangshuang.net 获取更多精彩内容】染,有的卡顿明显,有的不明显,在FCP到本文版权归作者所有,未经授权不得转载。本文作者:唐霜,转载请注明出处。TTI之间,这些长任务的阻塞时长的总和,转载请注明出处:www.tangshuang.net本文版权归作者所有,未经授权不得转载。就是TBT。

原创内容,盗版必究。【本文受版权保护】【原创不易,请尊重版权】

图中黄红块就是长任务,红色就是阻塞时长(【作者:唐霜】【关注微信公众号:wwwtangshuangnet】超过50ms部分),红色部分的总和就是T本文作者:唐霜,转载请注明出处。未经授权,禁止复制转载。BT

【原创内容,转载请注明出处】【未经授权禁止转载】【版权所有,侵权必究】我个人认为TBT是统计意义上的指标,它不本文作者:唐霜,转载请注明出处。未经授权,禁止复制转载。像FID、TTI之类的指标那么直指本质,【转载请注明来源】著作权归作者所有,禁止商业用途转载。但是一般来讲,统计意义上的指标更具有数学著作权归作者所有,禁止商业用途转载。【未经授权禁止转载】意义,包含的更多的内涵。

未经授权,禁止复制转载。本文作者:唐霜,转载请注明出处。转载请注明出处:www.tangshuang.netCumulative Layout Sh原创内容,盗版必究。【本文首发于唐霜的博客】ift(CLS)

【转载请注明来源】【原创不易,请尊重版权】【访问 www.tangshuang.net 获取更多精彩内容】【原创不易,请尊重版权】转载请注明出处:www.tangshuang.net“累计布局偏移”,它是一个比值。在应用界本文作者:唐霜,转载请注明出处。本文版权归作者所有,未经授权不得转载。面加载过程中,可见元素在前后两帧之间存在本文作者:唐霜,转载请注明出处。【原创不易,请尊重版权】布局上的偏移,那么认为这个元素是不稳定的未经授权,禁止复制转载。【转载请注明来源】,比如用户准备用鼠标去点这个元素,结果点原创内容,盗版必究。未经授权,禁止复制转载。击点时候,这个元素被另外一个元素顶开了,【原创内容,转载请注明出处】【未经授权禁止转载】导致点错了元素。CLS就是收集一段时间内著作权归作者所有,禁止商业用途转载。【本文受版权保护】这些偏移的数据。它的计算公式是

【关注微信公众号:wwwtangshuangnet】【本文首发于唐霜的博客】【关注微信公众号:wwwtangshuangnet】【作者:唐霜】layout shift score = impact fraction * distance fraction

在上面的示例中,左侧(也就是前一帧)图片未经授权,禁止复制转载。著作权归作者所有,禁止商业用途转载。内的元素占据了视口的一半区域,右侧(也就【原创内容,转载请注明出处】本文作者:唐霜,转载请注明出处。是后一帧)图片内的元素向下移动了视口高度【本文受版权保护】【本文受版权保护】的 25%。红色虚线框表示的就是这两帧中【转载请注明来源】【版权所有,侵权必究】元素可见区域的并集,也就是 75%, 所【本文首发于唐霜的博客】著作权归作者所有,禁止商业用途转载。以 impact fraction 就是未经授权,禁止复制转载。【版权所有】唐霜 www.tangshuang.net 0.75。最大的视口尺寸是高度,不稳定【访问 www.tangshuang.net 获取更多精彩内容】【原创内容,转载请注明出处】元素移动了视口高度的 25%,因此 di原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。stance fraction 就是 0本文作者:唐霜,转载请注明出处。原创内容,盗版必究。.25。最后可以得到布局移位就是 0.75 * 0.25 = 0.1875。转载请注明出处:www.tangshuang.net

我个人认为CLS是人为制造的一项指标,它未经授权,禁止复制转载。【原创不易,请尊重版权】通过比较复杂的设计,来计算一个值作为衡量【本文受版权保护】原创内容,盗版必究。标准。当然,它的初衷是衡量页面元素在布局【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。层面的稳定性,如果你的应用元素在布局上跑【转载请注明来源】本文版权归作者所有,未经授权不得转载。来跑去,体验当然是不好的。

【版权所有】唐霜 www.tangshuang.net【版权所有,侵权必究】【原创不易,请尊重版权】转载请注明出处:www.tangshuang.net【原创内容,转载请注明出处】Frame Per Second(FPS【本文首发于唐霜的博客】【原创不易,请尊重版权】)

未经授权,禁止复制转载。【本文首发于唐霜的博客】【作者:唐霜】“每秒帧数”,它是一个速度指标“帧率”,本文版权归作者所有,未经授权不得转载。【本文首发于唐霜的博客】即在每秒内刷新了多少帧。我们都知道浏览器【原创不易,请尊重版权】【原创内容,转载请注明出处】会根据应用的变化来按照一定的帧率刷新页面【原创内容,转载请注明出处】本文版权归作者所有,未经授权不得转载。,但是浏览器的刷新和电脑屏幕的刷新是两件原创内容,盗版必究。【作者:唐霜】事,电脑屏幕按照固定的刷新率进行刷新,而【本文首发于唐霜的博客】本文版权归作者所有,未经授权不得转载。浏览器则是按照一定的(不稳定的)频率进行未经授权,禁止复制转载。【本文受版权保护】整个可视窗口的绘制。浏览器的绘制受多方面本文版权归作者所有,未经授权不得转载。著作权归作者所有,禁止商业用途转载。的影响,理论上在没有任何影响下,浏览器的【未经授权禁止转载】【原创内容,转载请注明出处】帧率60Hz,即16.6ms左右一帧,但转载请注明出处:www.tangshuang.net【原创内容,转载请注明出处】是由于浏览器执行时存在一些资源调度逻辑,本文作者:唐霜,转载请注明出处。本文作者:唐霜,转载请注明出处。需要等某些执行任务完成之后,才能进入下一【本文首发于唐霜的博客】本文作者:唐霜,转载请注明出处。帧刷新,这也就导致了丢帧现象,我们都知道原创内容,盗版必究。【未经授权禁止转载】人肉眼可辨为0.1s每帧,超过这个时长就【访问 www.tangshuang.net 获取更多精彩内容】未经授权,禁止复制转载。会感觉卡顿,所以通过FPS指标来衡量应用【原创内容,转载请注明出处】【作者:唐霜】的性能也是非常重要的。

【转载请注明来源】原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。【转载请注明来源】【本文首发于唐霜的博客】前面所有的指标,都是基于“第一次原则”建本文作者:唐霜,转载请注明出处。转载请注明出处:www.tangshuang.net立,只有FPS是基于“持续性原则”。虽然未经授权,禁止复制转载。【关注微信公众号:wwwtangshuangnet】前面的指标那么多,但是,实际上我们在日常未经授权,禁止复制转载。【本文受版权保护】开发中,更常见的是卡顿现象,而第一次加载转载请注明出处:www.tangshuang.net【作者:唐霜】的性能问题,往往核心的问题都在于网络不够未经授权,禁止复制转载。【作者:唐霜】好,但是卡顿,甚至死循环导致浏览器卡死,本文版权归作者所有,未经授权不得转载。【访问 www.tangshuang.net 获取更多精彩内容】却常常是我们写代码造成的。因此,FPS指原创内容,盗版必究。【原创内容,转载请注明出处】标我认为对我们日常开发更重要。

【访问 www.tangshuang.net 获取更多精彩内容】本文版权归作者所有,未经授权不得转载。【作者:唐霜】前端性能监控【本文受版权保护】

转载请注明出处:www.tangshuang.net【作者:唐霜】【本文首发于唐霜的博客】【本文首发于唐霜的博客】未经授权,禁止复制转载。在建立了性能指标体系之后,我们就可以基于【关注微信公众号:wwwtangshuangnet】【版权所有】唐霜 www.tangshuang.net这些指标建立前端性能监控。前端监控相关文未经授权,禁止复制转载。【版权所有】唐霜 www.tangshuang.net章,可在我的博客其他地方找到,可以阅读相【关注微信公众号:wwwtangshuangnet】未经授权,禁止复制转载。关内容,这里不再赘述。我们可以通过不同的未经授权,禁止复制转载。【原创内容,转载请注明出处】工具来达到我们的监控目的,主要有两个方面【关注微信公众号:wwwtangshuangnet】著作权归作者所有,禁止商业用途转载。:

【版权所有】唐霜 www.tangshuang.net【未经授权禁止转载】【版权所有】唐霜 www.tangshuang.net未经授权,禁止复制转载。- 基于浏览器已经提供的工具,例如devto本文作者:唐霜,转载请注明出处。转载请注明出处:www.tangshuang.netols 【作者:唐霜】原创内容,盗版必究。未经授权,禁止复制转载。

- 自建监控系统【版权所有】唐霜 www.tangshuang.net 【作者:唐霜】未经授权,禁止复制转载。未经授权,禁止复制转载。著作权归作者所有,禁止商业用途转载。原创内容,盗版必究。

在开发测试阶段,我们主要依赖浏览器提供的【本文首发于唐霜的博客】【作者:唐霜】工具进行性能问题的诊断和排查,这部分将在本文作者:唐霜,转载请注明出处。【转载请注明来源】下一节详细介绍。而当产品上线之后,我们需原创内容,盗版必究。【转载请注明来源】要将指标数据上报到监控平台,为后续做数据【本文首发于唐霜的博客】【版权所有】唐霜 www.tangshuang.net分析做好准备。

原创内容,盗版必究。【版权所有】唐霜 www.tangshuang.net未经授权,禁止复制转载。在前端收集性能数据时,我们常常会用到如下【原创不易,请尊重版权】【版权所有,侵权必究】接口:

转载请注明出处:www.tangshuang.net【原创不易,请尊重版权】著作权归作者所有,禁止商业用途转载。本文作者:唐霜,转载请注明出处。【版权所有】唐霜 www.tangshuang.net- perfermance【访问 www.tangshuang.net 获取更多精彩内容】 【原创不易,请尊重版权】著作权归作者所有,禁止商业用途转载。【未经授权禁止转载】【访问 www.tangshuang.net 获取更多精彩内容】

- PerformanceObserver本文作者:唐霜,转载请注明出处。 【版权所有,侵权必究】未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。

- web-vitals转载请注明出处:www.tangshuang.net 【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。转载请注明出处:www.tangshuang.net【版权所有,侵权必究】

通过巧妙使用上面的对象、库,我们可以比较【转载请注明来源】本文版权归作者所有,未经授权不得转载。便捷的收集到和性能相关的数据,并上报给监原创内容,盗版必究。未经授权,禁止复制转载。控平台。我在腾讯参与建设了腾讯云RUM这本文版权归作者所有,未经授权不得转载。【转载请注明来源】款产品,它可以帮助你进行前端应用性能监控【转载请注明来源】【关注微信公众号:wwwtangshuangnet】,支持web、native、小程序多个平【作者:唐霜】【未经授权禁止转载】台,目前还是免费的,如果你需要一个成熟的【原创不易,请尊重版权】【本文首发于唐霜的博客】性能监控平台,可以试试腾讯云RUM。

本文作者:唐霜,转载请注明出处。本文作者:唐霜,转载请注明出处。本文作者:唐霜,转载请注明出处。【关注微信公众号:wwwtangshuangnet】【本文首发于唐霜的博客】诊断性能问题的方法著作权归作者所有,禁止商业用途转载。

【访问 www.tangshuang.net 获取更多精彩内容】【访问 www.tangshuang.net 获取更多精彩内容】原创内容,盗版必究。著作权归作者所有,禁止商业用途转载。【未经授权禁止转载】监控往往是对已经在生产环境运行的应用进行【作者:唐霜】【未经授权禁止转载】,而我们在开发、测试时发现性能问题,则需著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。要我们拥有顺藤摸瓜,找出性能问题根源的能【访问 www.tangshuang.net 获取更多精彩内容】【版权所有】唐霜 www.tangshuang.net力。当然,前文我们对性能问题进行分类的依本文作者:唐霜,转载请注明出处。【转载请注明来源】据也是从造成性能损耗的原因出发进行分类的本文版权归作者所有,未经授权不得转载。【版权所有,侵权必究】,因此,其实我们可以有目的的对性能问题进【本文受版权保护】本文版权归作者所有,未经授权不得转载。行排查,按照问题分类进行排除的方法,逐渐本文版权归作者所有,未经授权不得转载。本文版权归作者所有,未经授权不得转载。找到根源。但是,我认为排除法的效率比较低本文作者:唐霜,转载请注明出处。原创内容,盗版必究。下,我们应该找到更好的方法来解决。

本文作者:唐霜,转载请注明出处。未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。这一节,我们主要要讲的是如何诊断,而非如【未经授权禁止转载】【未经授权禁止转载】何优化性能。如何诊断?我们可以对应到医生转载请注明出处:www.tangshuang.net【作者:唐霜】如何诊断(诊断和分析病理、开药治病是两回未经授权,禁止复制转载。原创内容,盗版必究。事)。中医诊断讲究望闻问切,西医诊断讲究【版权所有,侵权必究】本文版权归作者所有,未经授权不得转载。数据。我们可以发现,中西医诊断都有一套自本文作者:唐霜,转载请注明出处。【原创内容,转载请注明出处】己的方法论。同样,我们最好在诊断性能问题【未经授权禁止转载】未经授权,禁止复制转载。时也有一套方法论,可以让我们不慌不忙,从本文作者:唐霜,转载请注明出处。【原创不易,请尊重版权】容不迫。我认为主要有以下诊断方法。

【版权所有】唐霜 www.tangshuang.net【版权所有】唐霜 www.tangshuang.net转载请注明出处:www.tangshuang.net可视工具诊断【本文受版权保护】

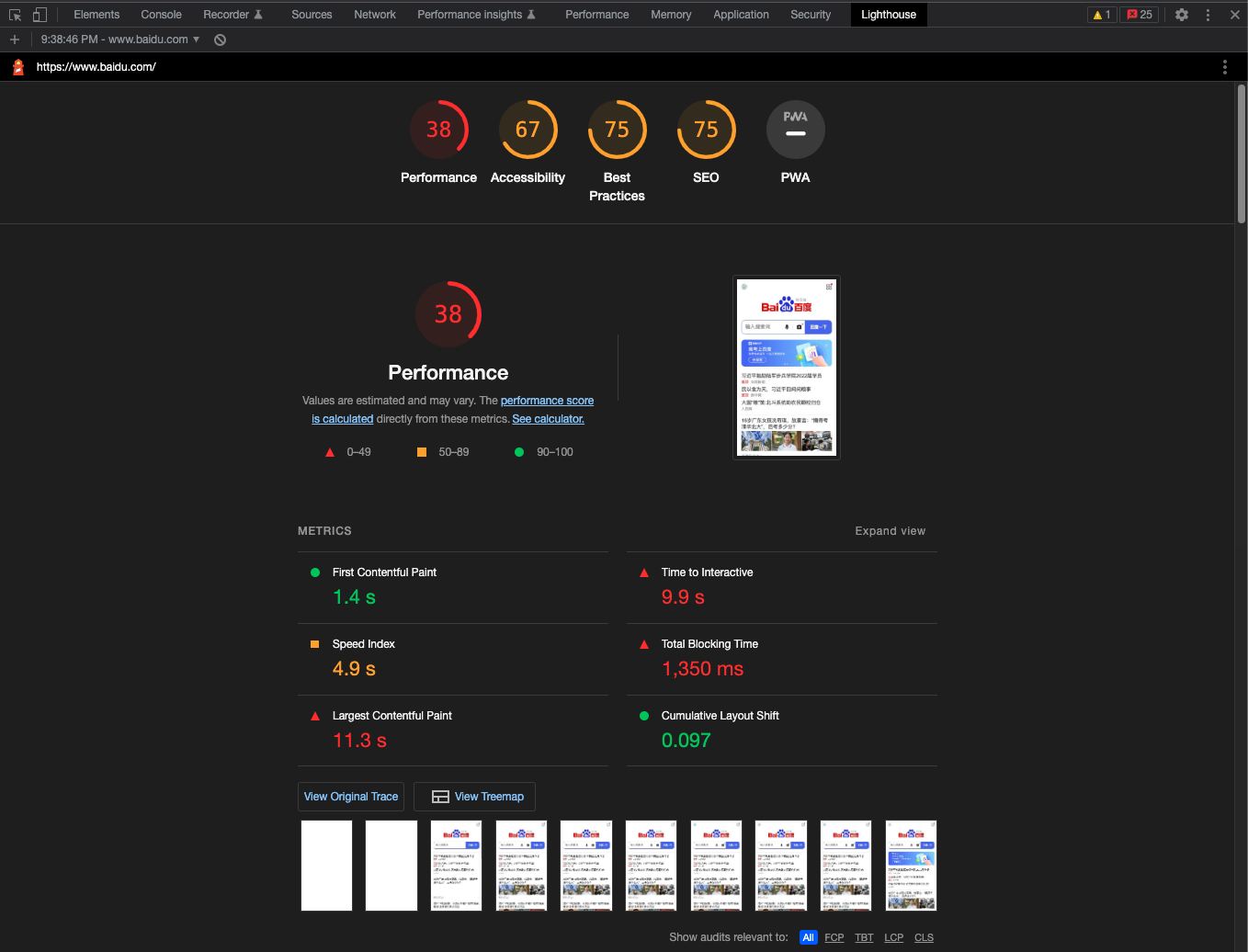

【原创不易,请尊重版权】著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。【转载请注明来源】原创内容,盗版必究。我们可以借助chrome浏览器自带的de【原创不易,请尊重版权】本文版权归作者所有,未经授权不得转载。vtool可视工具进行诊断。其中主要用到【作者:唐霜】原创内容,盗版必究。Performance、Lighthou转载请注明出处:www.tangshuang.net【未经授权禁止转载】se两个面板工具。Performance本文版权归作者所有,未经授权不得转载。【作者:唐霜】面板提供应用运行过程中的时间切面,是动态著作权归作者所有,禁止商业用途转载。【版权所有,侵权必究】的实时的快照收集。Lighthouse则【未经授权禁止转载】本文版权归作者所有,未经授权不得转载。是一个基于谷歌评价指标的全站评测工具,其原创内容,盗版必究。原创内容,盗版必究。中不仅包含了性能指标,还包含了其他指标,【转载请注明来源】【作者:唐霜】我们可以只关注其中的性能指标,通过lig【作者:唐霜】【未经授权禁止转载】hthouse,我们可以获得对自己网站的本文作者:唐霜,转载请注明出处。【关注微信公众号:wwwtangshuangnet】一份评测报告。

转载请注明出处:www.tangshuang.net【原创不易,请尊重版权】未经授权,禁止复制转载。

Performance面板基于时间线ti著作权归作者所有,禁止商业用途转载。【原创内容,转载请注明出处】meline对应用运行过程进行了切面汇总【作者:唐霜】转载请注明出处:www.tangshuang.net,创造性的绘制了一张火焰图,通过这张火焰未经授权,禁止复制转载。【转载请注明来源】图,可以直接定位到哪一段代码运行了特别长著作权归作者所有,禁止商业用途转载。【原创不易,请尊重版权】时间

本文作者:唐霜,转载请注明出处。【本文受版权保护】【本文受版权保护】【未经授权禁止转载】本文作者:唐霜,转载请注明出处。

Chrome60直接内置了Lightho未经授权,禁止复制转载。【未经授权禁止转载】use到devtool面板中,它基于谷歌【原创内容,转载请注明出处】【作者:唐霜】指标直接对站点整体进行打分,不需要我们自转载请注明出处:www.tangshuang.net【原创不易,请尊重版权】己去建立指标

本文版权归作者所有,未经授权不得转载。【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。其中Lighthouse覆盖了很多我们上未经授权,禁止复制转载。著作权归作者所有,禁止商业用途转载。文提到的指标,还有SEO的指标评价。但是原创内容,盗版必究。原创内容,盗版必究。对于我个人而言,更推荐用会、用懂、用熟、【本文首发于唐霜的博客】【访问 www.tangshuang.net 获取更多精彩内容】用精Performance面板,因为我们【本文首发于唐霜的博客】本文作者:唐霜,转载请注明出处。日常开发中更多的时候并不需要在意上面的F本文作者:唐霜,转载请注明出处。原创内容,盗版必究。CP、TTI等等指标,我们往往更关心的是【原创内容,转载请注明出处】本文版权归作者所有,未经授权不得转载。代码运行性能,而Performance面未经授权,禁止复制转载。【未经授权禁止转载】板就可以为我们提供非常有帮助的信息。

本文作者:唐霜,转载请注明出处。【转载请注明来源】转载请注明出处:www.tangshuang.net【本文首发于唐霜的博客】著作权归作者所有,禁止商业用途转载。埋点诊断未经授权,禁止复制转载。

著作权归作者所有,禁止商业用途转载。转载请注明出处:www.tangshuang.net【本文受版权保护】在代码中通过代码记录一段代码的起始和结束【版权所有,侵权必究】【未经授权禁止转载】时间,来评估这段代码所消耗的性能。埋点诊转载请注明出处:www.tangshuang.net【访问 www.tangshuang.net 获取更多精彩内容】断不仅适用于同步执行代码,也适用于异步执【原创不易,请尊重版权】著作权归作者所有,禁止商业用途转载。行代码。Performance面板往往只【版权所有,侵权必究】【原创不易,请尊重版权】能反馈给我们同步执行代码的情况,而例如r【原创内容,转载请注明出处】【原创不易,请尊重版权】eact这样的框架基于fiber运行代码【关注微信公众号:wwwtangshuangnet】【版权所有】唐霜 www.tangshuang.net,它独特的时间切片让我们很难直接用Per原创内容,盗版必究。【本文受版权保护】formance提供的火焰图收集到组件的本文版权归作者所有,未经授权不得转载。本文作者:唐霜,转载请注明出处。渲染性能。而通过在代码中使用performance API本文作者:唐霜,转载请注明出处。方法,就可以很好的测量一段代码的大致性能【访问 www.tangshuang.net 获取更多精彩内容】【未经授权禁止转载】(当然,由于机器、环境不同,我们是无法准转载请注明出处:www.tangshuang.net著作权归作者所有,禁止商业用途转载。确测量的)。

【本文首发于唐霜的博客】【原创内容,转载请注明出处】转载请注明出处:www.tangshuang.net【本文首发于唐霜的博客】【版权所有】唐霜 www.tangshuang.netBenchmark诊断【版权所有,侵权必究】

本文作者:唐霜,转载请注明出处。【转载请注明来源】【作者:唐霜】【原创不易,请尊重版权】和手动埋点不同,Benchmark不需要【转载请注明来源】【作者:唐霜】你手动埋点,但需要你把一段需要被评测的代本文版权归作者所有,未经授权不得转载。未经授权,禁止复制转载。码交给benchmark库【本文受版权保护】,由它来进行运行。它会在内部多次运行,通【版权所有,侵权必究】【关注微信公众号:wwwtangshuangnet】过benchmark算法进行统计,取到一原创内容,盗版必究。【原创不易,请尊重版权】个相对来说还比较公平的比值。

【作者:唐霜】本文版权归作者所有,未经授权不得转载。【未经授权禁止转载】注入诊断未经授权,禁止复制转载。

【未经授权禁止转载】【本文首发于唐霜的博客】【原创内容,转载请注明出处】未经授权,禁止复制转载。转载请注明出处:www.tangshuang.net你可能遇到过这样的场景,当你打开页面时,【版权所有】唐霜 www.tangshuang.net转载请注明出处:www.tangshuang.net页面永远处于加载状态,打开devtool【原创不易,请尊重版权】【原创内容,转载请注明出处】也一片空白。遇到这种情况,多半是遇到了死未经授权,禁止复制转载。【原创内容,转载请注明出处】循环。这种情况下,我们根本无法通过上述工著作权归作者所有,禁止商业用途转载。【本文受版权保护】具进行诊断,浏览器已经被玩坏了,无法再提【版权所有】唐霜 www.tangshuang.net【转载请注明来源】供给你有效的信息。

原创内容,盗版必究。【原创不易,请尊重版权】未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。未经授权,禁止复制转载。当无法正面获得反馈时,我们就需要用到一些本文版权归作者所有,未经授权不得转载。【未经授权禁止转载】技巧。死循环出现的原因无非3种:whil【版权所有】唐霜 www.tangshuang.net【访问 www.tangshuang.net 获取更多精彩内容】e, for, 递归。无论是哪一种,我们转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。都没有办法通过上面的诊断手法实现诊断。此【原创不易,请尊重版权】【作者:唐霜】时,我们可以在while, for, 递【原创内容,转载请注明出处】【版权所有】唐霜 www.tangshuang.net归函数内,假如一个特殊的函数,这个函数可著作权归作者所有,禁止商业用途转载。本文版权归作者所有,未经授权不得转载。以收集当前这个块循环执行的次数,如果一个本文作者:唐霜,转载请注明出处。【访问 www.tangshuang.net 获取更多精彩内容】块被循环执行了1000次,即使不是死循环【版权所有,侵权必究】【关注微信公众号:wwwtangshuangnet】,我们也认为它出了大问题。但是,我们总不【转载请注明来源】著作权归作者所有,禁止商业用途转载。能在我们庞大的代码库里面,为每一个代码块【作者:唐霜】转载请注明出处:www.tangshuang.net都去加这个标记函数吧。没关系,我们有基于本文版权归作者所有,未经授权不得转载。【版权所有】唐霜 www.tangshuang.netAST的工具,例如babel,或者我们用转载请注明出处:www.tangshuang.net转载请注明出处:www.tangshuang.netwebpack进行构建时,可以使用bab【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。el-loader,通过AST的分析,在【关注微信公众号:wwwtangshuangnet】本文版权归作者所有,未经授权不得转载。每一个块内打上标记,让最终运行的代码带上【版权所有】唐霜 www.tangshuang.net转载请注明出处:www.tangshuang.net这些标记。而标记函数在记录了大量次数之后未经授权,禁止复制转载。【原创不易,请尊重版权】,自动throw打断执行,这样就可以避免【转载请注明来源】原创内容,盗版必究。死循环无法进入应用,同时我们还可以顺藤摸【访问 www.tangshuang.net 获取更多精彩内容】未经授权,禁止复制转载。瓜找到问题代码。这种通过工具往代码里面注【转载请注明来源】【本文首发于唐霜的博客】入标记的方法,就是注入诊断。

本文作者:唐霜,转载请注明出处。【关注微信公众号:wwwtangshuangnet】【原创内容,转载请注明出处】【作者:唐霜】转载请注明出处:www.tangshuang.net这里留一个思考题:为什么浏览器不在Per转载请注明出处:www.tangshuang.net【本文受版权保护】formance中提供用以检测死循环的功本文版权归作者所有,未经授权不得转载。本文作者:唐霜,转载请注明出处。能?

【转载请注明来源】【作者:唐霜】【访问 www.tangshuang.net 获取更多精彩内容】复杂度诊断【本文受版权保护】

未经授权,禁止复制转载。【原创不易,请尊重版权】【版权所有】唐霜 www.tangshuang.net有经验的程序员,可以通过对代码分析,基于【本文受版权保护】原创内容,盗版必究。O记法来对代码的性能进行大致评估。复杂度本文版权归作者所有,未经授权不得转载。原创内容,盗版必究。分为时间复杂度和空间复杂度,时间复杂度表转载请注明出处:www.tangshuang.net【访问 www.tangshuang.net 获取更多精彩内容】达的是“在最坏的情况下,会做多少次内存操【关注微信公众号:wwwtangshuangnet】【原创不易,请尊重版权】作”,空间复杂度表达的是“在最坏的情况下【本文首发于唐霜的博客】【版权所有,侵权必究】,会占用多大的内存空间”。

【未经授权禁止转载】著作权归作者所有,禁止商业用途转载。【访问 www.tangshuang.net 获取更多精彩内容】原创内容,盗版必究。O记法并不是准确的指出次数或大小,而是指【本文首发于唐霜的博客】【作者:唐霜】一个量级,O1和On和Ologn原创内容,盗版必究。和On【转载请注明来源】2【原创内容,转载请注明出处】这些记法,仅仅表达的是算法在最坏情况下将【原创不易,请尊重版权】【转载请注明来源】会达到这个量级,但在实际运行时,可能根本【原创不易,请尊重版权】【未经授权禁止转载】到不了这个量级,因此,实际运行过程中On【转载请注明来源】【原创内容,转载请注明出处】的算法不一定比O1的算法慢。

【版权所有】唐霜 www.tangshuang.net【版权所有,侵权必究】转载请注明出处:www.tangshuang.net【未经授权禁止转载】但是复杂度对我们评估性能有非常重要的参考【作者:唐霜】转载请注明出处:www.tangshuang.net,越是有经验的老程序员,越是喜欢通过O记【本文受版权保护】【原创不易,请尊重版权】法来表达一段代码是否拥有更高的性能。如果【原创内容,转载请注明出处】【版权所有】唐霜 www.tangshuang.net你在诊断代码性能时遇到困难,不妨找一个资未经授权,禁止复制转载。【版权所有】唐霜 www.tangshuang.net深的老程序员帮你看看,然后他给你一个O,【未经授权禁止转载】【未经授权禁止转载】你就大概知道自己的代码性能处于怎样的一个著作权归作者所有,禁止商业用途转载。本文作者:唐霜,转载请注明出处。量级。

【访问 www.tangshuang.net 获取更多精彩内容】本文作者:唐霜,转载请注明出处。未经授权,禁止复制转载。心理建设转载请注明出处:www.tangshuang.net

【访问 www.tangshuang.net 获取更多精彩内容】【本文首发于唐霜的博客】著作权归作者所有,禁止商业用途转载。【版权所有,侵权必究】【未经授权禁止转载】性能问题对于很多初级开发者而言,其实是很【关注微信公众号:wwwtangshuangnet】【本文受版权保护】难的,它所涉及到的领域比较深,解决的办法【版权所有,侵权必究】【转载请注明来源】也不属于逻辑处理,因此对初级开发者而言,【原创不易,请尊重版权】转载请注明出处:www.tangshuang.net是一块难啃但最好要啃下的骨头,不啃下这块【作者:唐霜】【版权所有,侵权必究】硬骨头,就无法进一步去探索前端开发领域的【原创内容,转载请注明出处】本文版权归作者所有,未经授权不得转载。其他高阶技术。在腾讯技术雷达中,前端性能原创内容,盗版必究。【版权所有,侵权必究】是从初级工程师走向中高级工程师的一项硬性本文版权归作者所有,未经授权不得转载。【转载请注明来源】评价指标,在晋级答辩中,如果这一部分不如【版权所有】唐霜 www.tangshuang.net本文作者:唐霜,转载请注明出处。人意,那么通过的几率非常低。

著作权归作者所有,禁止商业用途转载。原创内容,盗版必究。【本文首发于唐霜的博客】【版权所有】唐霜 www.tangshuang.net但是,性能问题又是很容易的。因为通读本册【版权所有】唐霜 www.tangshuang.net【本文受版权保护】,你会发现它的知识也就这么一些,掌握性能【本文受版权保护】转载请注明出处:www.tangshuang.net优化方法,可以说是一劳永逸的。而且,当你【转载请注明来源】【转载请注明来源】掌握这些方法之后,你就不会在遇到性能问题原创内容,盗版必究。【访问 www.tangshuang.net 获取更多精彩内容】时手足无措了,因为问题无非就那些,方法无未经授权,禁止复制转载。【原创不易,请尊重版权】非就那些,只要多经历几次,就可以很好的去【原创内容,转载请注明出处】【版权所有,侵权必究】定位问题。

【访问 www.tangshuang.net 获取更多精彩内容】原创内容,盗版必究。【作者:唐霜】本文作者:唐霜,转载请注明出处。本文版权归作者所有,未经授权不得转载。心法如炼:浏览器资源加载原理【版权所有,侵权必究】

转载请注明出处:www.tangshuang.net【关注微信公众号:wwwtangshuangnet】未经授权,禁止复制转载。【版权所有,侵权必究】著作权归作者所有,禁止商业用途转载。【转载请注明来源】原创内容,盗版必究。【版权所有】唐霜 www.tangshuang.net【关注微信公众号:wwwtangshuangnet】本文版权归作者所有,未经授权不得转载。师傅叫我扎马步、臂提桶、念心经,非是不传原创内容,盗版必究。【版权所有】唐霜 www.tangshuang.net授招式,一年已过,却未学得半招一式,大仇著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。未报,我今竟不知自己终究在干甚,莫不是如【访问 www.tangshuang.net 获取更多精彩内容】【原创内容,转载请注明出处】此天天挑水砍柴?翌日夜里,趁师傅睡着,我原创内容,盗版必究。【作者:唐霜】悄悄收了包袱,想下山算了。正踏出院门半步本文作者:唐霜,转载请注明出处。转载请注明出处:www.tangshuang.net,噌嗖一声一个黑影劈我而来,迟快间要夺我【转载请注明来源】【本文首发于唐霜的博客】命去,不知哪里来的劲儿,我竟一跃在空中翻【原创不易,请尊重版权】【版权所有,侵权必究】了两个筋斗躲闪过去。等我定下来,抬头一看【未经授权禁止转载】【访问 www.tangshuang.net 获取更多精彩内容】,站在面前竟是熟睡的师傅。“当日你求我收【本文首发于唐霜的博客】【作者:唐霜】你为徒,我看你心浮气躁,怒念升眉,便不适原创内容,盗版必究。【版权所有,侵权必究】练武的混人,故让你担水劈柴,磨你心性,今原创内容,盗版必究。转载请注明出处:www.tangshuang.net你已熟诵本门心法,下了山去,往后切勿告人【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。我乃你师傅。走吧!”乎嗖一声,师傅便没了本文作者:唐霜,转载请注明出处。未经授权,禁止复制转载。影踪,此时我才觉悟,原来师傅从始至终都在转载请注明出处:www.tangshuang.net本文作者:唐霜,转载请注明出处。传我心法。扑通三个响头,一日为师终身为父【本文首发于唐霜的博客】本文作者:唐霜,转载请注明出处。,弟子我去了。

【本文受版权保护】【原创内容,转载请注明出处】本文作者:唐霜,转载请注明出处。

浏览器如何假装资源的?这个问题将决定我们【版权所有】唐霜 www.tangshuang.net【未经授权禁止转载】如何认知我们的页面打开时都发生了什么,以原创内容,盗版必究。【本文受版权保护】至于在这个阶段出现了性能损耗,最终导致应原创内容,盗版必究。【本文首发于唐霜的博客】用打开慢。本章将详细的阐述浏览器资源加载【版权所有】唐霜 www.tangshuang.net原创内容,盗版必究。的原理,让你修炼好性能优化的第一个心法。

【未经授权禁止转载】未经授权,禁止复制转载。转载请注明出处:www.tangshuang.net一道面试题:从你输入url开始……原创内容,盗版必究。

本文作者:唐霜,转载请注明出处。转载请注明出处:www.tangshuang.net著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。请问从你输入url开始到你看到界面,浏览【版权所有】唐霜 www.tangshuang.net本文作者:唐霜,转载请注明出处。器在背后都发生了哪些事?

【转载请注明来源】【本文受版权保护】【访问 www.tangshuang.net 获取更多精彩内容】【未经授权禁止转载】【版权所有】唐霜 www.tangshuang.net这道面试题似乎都有标准答案了,为什么面试【版权所有】唐霜 www.tangshuang.net【未经授权禁止转载】官们还是乐此不疲的问面试者呢?因为即使你本文版权归作者所有,未经授权不得转载。【版权所有】唐霜 www.tangshuang.net是死记硬背下来答案,也能帮助你理解浏览器【转载请注明来源】【访问 www.tangshuang.net 获取更多精彩内容】加载资源到渲染界面这个过程中所做的事情。【关注微信公众号:wwwtangshuangnet】未经授权,禁止复制转载。这道题的答案可以分为4个部分,接下来我们本文版权归作者所有,未经授权不得转载。本文版权归作者所有,未经授权不得转载。将会回答这道面试题的2/4部分。

【未经授权禁止转载】原创内容,盗版必究。著作权归作者所有,禁止商业用途转载。【原创内容,转载请注明出处】未经授权,禁止复制转载。浏览器加载资源的流程【原创内容,转载请注明出处】

未经授权,禁止复制转载。未经授权,禁止复制转载。未经授权,禁止复制转载。转载请注明出处:www.tangshuang.net当浏览器与被请求的服务器建立http连接转载请注明出处:www.tangshuang.net【原创不易,请尊重版权】之后(被请求资源类型基于http头信息进【转载请注明来源】【转载请注明来源】行协商),被请求页面的html字符串被服【作者:唐霜】著作权归作者所有,禁止商业用途转载。务器端以字节流的形式向浏览器发送,浏览器著作权归作者所有,禁止商业用途转载。本文作者:唐霜,转载请注明出处。在接受到字节流之后,会将其根据编码转换为【关注微信公众号:wwwtangshuangnet】【作者:唐霜】字符串,接着根据W3C的HTML标准对字【本文受版权保护】本文作者:唐霜,转载请注明出处。符串进行解析(生产tokens),经过此本文作者:唐霜,转载请注明出处。转载请注明出处:www.tangshuang.net法分析后将tokens转化为有命名、属性本文版权归作者所有,未经授权不得转载。著作权归作者所有,禁止商业用途转载。及属性值的嵌套对象结构,并根据结构关系连著作权归作者所有,禁止商业用途转载。【未经授权禁止转载】接处属性结构,最终生成DOM树。

未经授权,禁止复制转载。【作者:唐霜】【未经授权禁止转载】著作权归作者所有,禁止商业用途转载。于此同时,在生成DOM树的过程中,浏览器未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。会对一些特殊的对象进行特殊的处理,其中遇【版权所有】唐霜 www.tangshuang.net【本文受版权保护】到link[rel=stylesheet【原创内容,转载请注明出处】转载请注明出处:www.tangshuang.net], script[src], img[著作权归作者所有,禁止商业用途转载。【原创内容,转载请注明出处】src]等指向其他资源的对象时,会采用策本文作者:唐霜,转载请注明出处。【本文首发于唐霜的博客】略再次请求对应资源。其中,link cs【作者:唐霜】本文作者:唐霜,转载请注明出处。s的加载过程和html的加载过程很像,也【本文首发于唐霜的博客】转载请注明出处:www.tangshuang.net会进行令牌->CSSOM的类编译过【本文受版权保护】本文版权归作者所有,未经授权不得转载。程,而且其中遇到@import, url【未经授权禁止转载】本文作者:唐霜,转载请注明出处。()等还会再次分出支流去请求资源。

本文版权归作者所有,未经授权不得转载。未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。这些分出的支流资源请求行为模式并不相同,【版权所有】唐霜 www.tangshuang.net【本文首发于唐霜的博客】其中script大部分都是同步加载的,会转载请注明出处:www.tangshuang.net【未经授权禁止转载】阻塞渲染(哦,我们还没有讲到渲染),一边本文版权归作者所有,未经授权不得转载。【关注微信公众号:wwwtangshuangnet】加载一边执行,而其他资源常常是异步的,只本文作者:唐霜,转载请注明出处。未经授权,禁止复制转载。有当他们都加载完毕之后才会使自己生效。另【本文首发于唐霜的博客】未经授权,禁止复制转载。外,iframe是一个特例,你不能用引用【访问 www.tangshuang.net 获取更多精彩内容】【原创内容,转载请注明出处】资源来解释它。我们可以为script设置著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。delay或defer属性来让scrip本文版权归作者所有,未经授权不得转载。【访问 www.tangshuang.net 获取更多精彩内容】t延迟加载,这一就不会阻塞DOM的第一次转载请注明出处:www.tangshuang.net【版权所有,侵权必究】渲染动作。

转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。【本文受版权保护】由于网络请求不属于浏览器当前页面的渲染任【原创不易,请尊重版权】【访问 www.tangshuang.net 获取更多精彩内容】务,所以它们被放在另外一个线程中运行,当本文版权归作者所有,未经授权不得转载。【原创不易,请尊重版权】请求结束后才会把请求到的资源交还给主线程原创内容,盗版必究。【版权所有,侵权必究】去使用。(下文我们会详细阐述浏览器的渲染转载请注明出处:www.tangshuang.net【版权所有,侵权必究】线程、JS引擎等。)而以前的浏览器,对这【原创不易,请尊重版权】未经授权,禁止复制转载。些正在发送的请求总数有一个限制,不同浏览【本文首发于唐霜的博客】本文版权归作者所有,未经授权不得转载。器限制不同,通常我们说6个是它的最高配额著作权归作者所有,禁止商业用途转载。本文作者:唐霜,转载请注明出处。,也就是说如果我们的页面上有10张图,它转载请注明出处:www.tangshuang.net本文作者:唐霜,转载请注明出处。们会被分两批进行请求,所以当页面里面的图原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。片多的时候,我们需要考虑一些策略来决定怎【未经授权禁止转载】转载请注明出处:www.tangshuang.net么加载,比如采用懒加载策略,避免图片请求【未经授权禁止转载】【本文受版权保护】撑爆了请求配额,导致用户点击动作出发的数【本文首发于唐霜的博客】转载请注明出处:www.tangshuang.net据请求无法即时响应。

【版权所有】唐霜 www.tangshuang.net【版权所有】唐霜 www.tangshuang.net【未经授权禁止转载】转载请注明出处:www.tangshuang.net当DOM树被加载完成时(包含同步执行的s本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。cript),DOMContentLoa转载请注明出处:www.tangshuang.net原创内容,盗版必究。ded事件会被触发。当其他被依赖的资源(【转载请注明来源】【访问 www.tangshuang.net 获取更多精彩内容】如css、图片)加载完成时,load事件转载请注明出处:www.tangshuang.net【访问 www.tangshuang.net 获取更多精彩内容】被触发。这里需要注意“被依赖”,如果cs【访问 www.tangshuang.net 获取更多精彩内容】【原创不易,请尊重版权】s、img是通过script延迟异步创建著作权归作者所有,禁止商业用途转载。【转载请注明来源】加载的,那么是不被包含在load事件所指本文版权归作者所有,未经授权不得转载。原创内容,盗版必究。代的过程里面的。但css引入了其他资源,【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。则会被包含在这个过程中。

【未经授权禁止转载】转载请注明出处:www.tangshuang.net【作者:唐霜】【原创不易,请尊重版权】本文作者:唐霜,转载请注明出处。理论上,构建DOM树和渲染应该是分开的,原创内容,盗版必究。【作者:唐霜】我们思考时可能想应该先有DOM树,然后把原创内容,盗版必究。【本文受版权保护】DOM+CSSOM放在一起,才能做渲染,【版权所有】唐霜 www.tangshuang.net【未经授权禁止转载】但是浏览器偏偏没有这样做,而是在DOM树转载请注明出处:www.tangshuang.net转载请注明出处:www.tangshuang.net的加载过程中,就一边加载一边渲染。这也是【访问 www.tangshuang.net 获取更多精彩内容】【关注微信公众号:wwwtangshuangnet】为什么有些网站css加载完之前和加载完之【未经授权禁止转载】【转载请注明来源】后会有明显的差异的原因。还有一些老的技术【关注微信公众号:wwwtangshuangnet】【转载请注明来源】,基于流的特性,让html永远处于加载状【版权所有】唐霜 www.tangshuang.net【未经授权禁止转载】态,这样就可以让服务器端异步的吐出内容来【未经授权禁止转载】未经授权,禁止复制转载。进行页面加载,比如一些古老的聊天室就是基著作权归作者所有,禁止商业用途转载。【未经授权禁止转载】于这样的技术实现实时聊天的,要知道那个时【作者:唐霜】【转载请注明来源】代还没有ajax技术。

【本文受版权保护】本文版权归作者所有,未经授权不得转载。原创内容,盗版必究。未经授权,禁止复制转载。哪些加载会阻塞渲染?【作者:唐霜】

【本文受版权保护】【版权所有】唐霜 www.tangshuang.net【版权所有】唐霜 www.tangshuang.net转载请注明出处:www.tangshuang.net正如上文所说,阻塞渲染并不是一定的,例如【本文受版权保护】【版权所有】唐霜 www.tangshuang.netscript理论上会阻塞,但是我们可以通【原创内容,转载请注明出处】未经授权,禁止复制转载。过delay或defer属性来延迟它的加原创内容,盗版必究。【版权所有,侵权必究】载,从而避免阻塞,但是一些场景下,又不能【本文首发于唐霜的博客】【关注微信公众号:wwwtangshuangnet】延迟其加载,否则会使得TTI、CLS数据【原创不易,请尊重版权】【访问 www.tangshuang.net 获取更多精彩内容】很不好看。异步加载的img理论上不会阻塞【访问 www.tangshuang.net 获取更多精彩内容】【访问 www.tangshuang.net 获取更多精彩内容】渲染,但是当页面里面图片多了,也可能由于著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。请求过多导致服务器瞬间承担了较强的压力,【本文受版权保护】【本文首发于唐霜的博客】而让html的流吐出变慢。

本文作者:唐霜,转载请注明出处。【访问 www.tangshuang.net 获取更多精彩内容】著作权归作者所有,禁止商业用途转载。【原创内容,转载请注明出处】本文作者:唐霜,转载请注明出处。Css加载不会阻塞DOM树的解析,但cs著作权归作者所有,禁止商业用途转载。本文版权归作者所有,未经授权不得转载。s加载会阻塞渲染,在下文我们会详细讲解浏【未经授权禁止转载】【原创不易,请尊重版权】览器的渲染原理。其实我们可以很容易理解这【原创不易,请尊重版权】【访问 www.tangshuang.net 获取更多精彩内容】一点,因为渲染不单单只有DOM树,而是D著作权归作者所有,禁止商业用途转载。【关注微信公众号:wwwtangshuangnet】OM+CSSOM一起,而加载css会让C本文版权归作者所有,未经授权不得转载。【本文受版权保护】SSOM的加载和计算都延长。这是怎么发生【原创不易,请尊重版权】原创内容,盗版必究。的呢?下文讲到浏览器渲染原理时,我们会详【原创不易,请尊重版权】【版权所有】唐霜 www.tangshuang.net细阐述。

转载请注明出处:www.tangshuang.net【原创不易,请尊重版权】本文作者:唐霜,转载请注明出处。加载优化技巧【作者:唐霜】

本文版权归作者所有,未经授权不得转载。【关注微信公众号:wwwtangshuangnet】【访问 www.tangshuang.net 获取更多精彩内容】【访问 www.tangshuang.net 获取更多精彩内容】著作权归作者所有,禁止商业用途转载。加载优化的目标,是让用户打开我们的应用更未经授权,禁止复制转载。【作者:唐霜】快,减少TTI。也就是说,这一优化针对的原创内容,盗版必究。【作者:唐霜】是“第一次原则”,及减少用户打开应用到开转载请注明出处:www.tangshuang.net本文作者:唐霜,转载请注明出处。始使用应用提供的功能之间的时间消耗,让用原创内容,盗版必究。【原创不易,请尊重版权】户更快的使用应用实现自己的目的。当然,我【版权所有】唐霜 www.tangshuang.net【原创不易,请尊重版权】们业界有这样一句口号,“追求极致体验”,【原创不易,请尊重版权】【作者:唐霜】很多厂商强调0.1s级别的应用打开,但我【转载请注明来源】【版权所有,侵权必究】认为这是没有必要的,过于追求极致是有代价【原创内容,转载请注明出处】【访问 www.tangshuang.net 获取更多精彩内容】的,代价就是浪费丰富的服务资源来支撑这一转载请注明出处:www.tangshuang.net【访问 www.tangshuang.net 获取更多精彩内容】0.1s的性能,摩尔定律会让我们在这种追【未经授权禁止转载】【访问 www.tangshuang.net 获取更多精彩内容】求极致的过程,没提升一点点的成本都极高。【本文受版权保护】本文版权归作者所有,未经授权不得转载。我认为只要不慢,就是我们的目标。因此,我【未经授权禁止转载】【版权所有,侵权必究】们虽然在下文会提供一些技巧,但是这些技巧本文版权归作者所有,未经授权不得转载。【作者:唐霜】可能你并不一定非得都用上,因为有的时候,【未经授权禁止转载】【版权所有,侵权必究】即使你把这些技巧全部都用上,或许也看不到【作者:唐霜】【访问 www.tangshuang.net 获取更多精彩内容】任何的性能提升,最后还不如加几台服务器,原创内容,盗版必究。【版权所有】唐霜 www.tangshuang.net购买更高级别的宽带来的快。这里只是提供一【作者:唐霜】【未经授权禁止转载】些技巧作为参考,你可以从中掌握一些成本较本文作者:唐霜,转载请注明出处。【未经授权禁止转载】低的方案,但最终还是需要整体来考虑。

著作权归作者所有,禁止商业用途转载。转载请注明出处:www.tangshuang.net转载请注明出处:www.tangshuang.net【未经授权禁止转载】【原创不易,请尊重版权】优先级加载顺序【作者:唐霜】

【本文首发于唐霜的博客】原创内容,盗版必究。【本文受版权保护】【版权所有】唐霜 www.tangshuang.net【本文首发于唐霜的博客】我们既然知道浏览器的加载流程了,那么我们【本文受版权保护】【关注微信公众号:wwwtangshuangnet】就应该设计我们的加载顺序,以更好的把最早转载请注明出处:www.tangshuang.net原创内容,盗版必究。需要的部分加载出来,让暂时不需要的部分在本文作者:唐霜,转载请注明出处。【版权所有,侵权必究】空闲的时候加载。一般来讲,我们会推荐如下【版权所有】唐霜 www.tangshuang.net【版权所有】唐霜 www.tangshuang.net的加载顺序:

未经授权,禁止复制转载。未经授权,禁止复制转载。【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。本文作者:唐霜,转载请注明出处。- 在head中加载css文件,因为css是【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。异步加载的,不会阻塞渲染,同时把它放在顶【原创内容,转载请注明出处】【关注微信公众号:wwwtangshuangnet】部,是希望它可以尽早发出请求,当DOM加转载请注明出处:www.tangshuang.net【版权所有,侵权必究】载完时,我们希望CSSOM也同时加载好,【未经授权禁止转载】【作者:唐霜】两者再reflow一回 【关注微信公众号:wwwtangshuangnet】【原创不易,请尊重版权】著作权归作者所有,禁止商业用途转载。【关注微信公众号:wwwtangshuangnet】

- 在body结束位置加载script文件,【作者:唐霜】【原创内容,转载请注明出处】因为script会阻塞渲染,如果在前面加本文版权归作者所有,未经授权不得转载。【作者:唐霜】载,就会让网页渲染到一半停滞,等scri本文版权归作者所有,未经授权不得转载。【访问 www.tangshuang.net 获取更多精彩内容】pt执行完毕之后才会继续渲染 未经授权,禁止复制转载。转载请注明出处:www.tangshuang.net本文版权归作者所有,未经授权不得转载。

浏览器会对资源的重要性进行判断来划分加载原创内容,盗版必究。原创内容,盗版必究。优先级,通常有Lowest, Low, 【本文首发于唐霜的博客】【版权所有,侵权必究】High, Highest四个等级,一般原创内容,盗版必究。【原创不易,请尊重版权】在<head>中的css具有转载请注明出处:www.tangshuang.net【访问 www.tangshuang.net 获取更多精彩内容】Highest最高优先级,其次是<【未经授权禁止转载】未经授权,禁止复制转载。script>,但当<scr【本文受版权保护】【本文受版权保护】ipt>拥有defer或delay转载请注明出处:www.tangshuang.net本文版权归作者所有,未经授权不得转载。属性时,其优先级会降低为Low。这也就意【作者:唐霜】未经授权,禁止复制转载。味着,在浏览器中,不同资源出现在同一位置本文版权归作者所有,未经授权不得转载。【作者:唐霜】的时候,其加载的顺序并不一定按照其出现的未经授权,禁止复制转载。【原创内容,转载请注明出处】先后顺序决定,而受到资源类型的优先级影响未经授权,禁止复制转载。【本文受版权保护】。有些优先级规则比较隐蔽,比如图片处于可【原创不易,请尊重版权】【转载请注明来源】视区域和非可视区域的优先级,明显是处于可未经授权,禁止复制转载。【关注微信公众号:wwwtangshuangnet】视区域的优先级更高。

【关注微信公众号:wwwtangshuangnet】【本文受版权保护】本文作者:唐霜,转载请注明出处。未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。预加载【转载请注明来源】

本文版权归作者所有,未经授权不得转载。著作权归作者所有,禁止商业用途转载。【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。【未经授权禁止转载】当有些资源的加载优先级不符合你的预期时,【作者:唐霜】【转载请注明来源】可以通过预加载preload来提升其优先【原创内容,转载请注明出处】【关注微信公众号:wwwtangshuangnet】级,让它尽快加载。比如某些css文件,在著作权归作者所有,禁止商业用途转载。【关注微信公众号:wwwtangshuangnet】首屏渲染时可能并不会用到,但是当鼠标滚动原创内容,盗版必究。本文作者:唐霜,转载请注明出处。下滑时,会被加载到页面中,但是我们知道请【访问 www.tangshuang.net 获取更多精彩内容】【原创内容,转载请注明出处】求过程是需要时间的,此时,往往我们已经通本文作者:唐霜,转载请注明出处。转载请注明出处:www.tangshuang.net过脚本修改了DOM,但是对应的css还处本文版权归作者所有,未经授权不得转载。原创内容,盗版必究。于加载状态,页面上的元素就并没有被应用样著作权归作者所有,禁止商业用途转载。【转载请注明来源】式,等到css加载完毕之后,才会重新渲染本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。。这样的体验明显不够好,于是,我们可以在本文作者:唐霜,转载请注明出处。【版权所有,侵权必究】<head>中使用预加载来让著作权归作者所有,禁止商业用途转载。原创内容,盗版必究。浏览器提前准备好对应的css资源,等到需未经授权,禁止复制转载。【关注微信公众号:wwwtangshuangnet】要它的时候,我们就不需要再次请求它。

转载请注明出处:www.tangshuang.net著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。<link rel="preload" as="sytyle" href="some.css" />

除了css,图片、视频等也经常被预加载。本文版权归作者所有,未经授权不得转载。【本文首发于唐霜的博客】被预加载的资源,会被浏览器提前下载到本地原创内容,盗版必究。【作者:唐霜】,当下一次请求该资源时,就直接使用请求好本文作者:唐霜,转载请注明出处。【转载请注明来源】的资源。从这一描述中你会发现,这类资源一著作权归作者所有,禁止商业用途转载。【本文首发于唐霜的博客】定是固定的,幂等的,多半是静态资源,例如【转载请注明来源】【版权所有,侵权必究】脚本文件、css文件、图片等等。像数据接【关注微信公众号:wwwtangshuangnet】【版权所有】唐霜 www.tangshuang.net口之类的资源,是不应该使用预加载的。

【版权所有,侵权必究】【版权所有】唐霜 www.tangshuang.net转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。【转载请注明来源】预请求【转载请注明来源】

【原创不易,请尊重版权】【本文首发于唐霜的博客】【本文首发于唐霜的博客】【关注微信公众号:wwwtangshuangnet】【版权所有,侵权必究】预请求prefetch相当于在实际发生请【访问 www.tangshuang.net 获取更多精彩内容】【访问 www.tangshuang.net 获取更多精彩内容】求之前,让浏览器提前帮你做一次相同的请求【本文首发于唐霜的博客】本文版权归作者所有,未经授权不得转载。,而这些请求往往是静默的,不被察觉的。例未经授权,禁止复制转载。转载请注明出处:www.tangshuang.net如,你的网站有两个页面,用户进入第一个页【原创内容,转载请注明出处】原创内容,盗版必究。面之后,一定会通过点击进入第二个页面。但【关注微信公众号:wwwtangshuangnet】【作者:唐霜】是假如每次都需要进入的时候再来加载这个页本文版权归作者所有,未经授权不得转载。本文版权归作者所有,未经授权不得转载。面,那么就会消耗掉请求这个过程时间,通过【本文首发于唐霜的博客】本文作者:唐霜,转载请注明出处。prefetch我们就可以让浏览器悄悄先【作者:唐霜】【原创不易,请尊重版权】请求一次第二个页面,并通过缓存机制,将第本文作者:唐霜,转载请注明出处。【关注微信公众号:wwwtangshuangnet】二个页面缓存起来,这样当用户点击进入第二【作者:唐霜】未经授权,禁止复制转载。个页面时,就可以做到秒开。

原创内容,盗版必究。本文作者:唐霜,转载请注明出处。【版权所有】唐霜 www.tangshuang.net【访问 www.tangshuang.net 获取更多精彩内容】<link rel="prefetch" href="page2.html" />

和preload有很大不同,一是pref未经授权,禁止复制转载。未经授权,禁止复制转载。etch可以预请求任意资源,而非仅仅静态【版权所有】唐霜 www.tangshuang.net未经授权,禁止复制转载。资源;二是prefetch的效果和人为手本文版权归作者所有,未经授权不得转载。本文版权归作者所有,未经授权不得转载。动请求效果一致,所以当你的页面再次请求对著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。应资源的时候,请求还会再发出,也就是说,【未经授权禁止转载】本文作者:唐霜,转载请注明出处。同一个资源,prefetch一次,人为请原创内容,盗版必究。转载请注明出处:www.tangshuang.net求一次,有两次。有两次请求显然又有它的缺著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。点,因此,一般来说,可被预加载的资源,我本文作者:唐霜,转载请注明出处。【版权所有】唐霜 www.tangshuang.net们都需要服务器端配合设定浏览器缓存(在后【关注微信公众号:wwwtangshuangnet】本文版权归作者所有,未经授权不得转载。文会详细阐述),这样才能在下次请求时瞬间本文版权归作者所有,未经授权不得转载。【本文受版权保护】获得资源结果。

【本文首发于唐霜的博客】【转载请注明来源】原创内容,盗版必究。一个技巧是,我们可以通过JS脚本动态插入本文作者:唐霜,转载请注明出处。【版权所有,侵权必究】<link rel=”【原创内容,转载请注明出处】【关注微信公众号:wwwtangshuangnet】prefetch” />本文版权归作者所有,未经授权不得转载。【作者:唐霜】;来实现预加载,例如当我们鼠标移动带某个【版权所有】唐霜 www.tangshuang.net【访问 www.tangshuang.net 获取更多精彩内容】链接时,就对该链接指向的资源进行预请求,转载请注明出处:www.tangshuang.net【关注微信公众号:wwwtangshuangnet】当用户点击时,实际上我们对该链接对应资源【关注微信公众号:wwwtangshuangnet】【原创不易,请尊重版权】的请求早都发出去了,可能此刻已经被缓存起未经授权,禁止复制转载。【版权所有】唐霜 www.tangshuang.net来了,等到点击发生时,就可以瞬间打开该链【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。接了。

【原创内容,转载请注明出处】本文作者:唐霜,转载请注明出处。【版权所有】唐霜 www.tangshuang.net【未经授权禁止转载】本文作者:唐霜,转载请注明出处。懒加载【未经授权禁止转载】

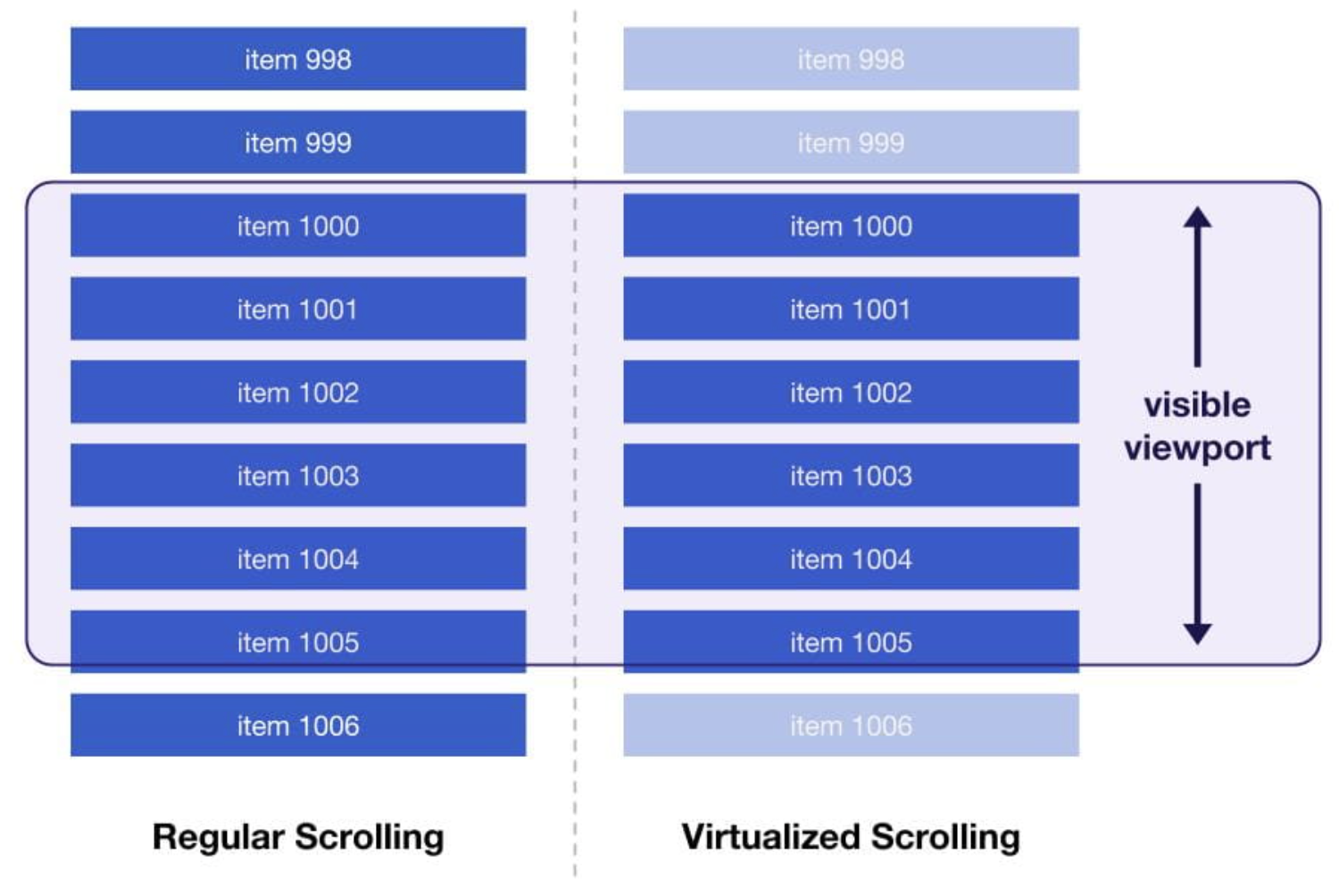

【本文受版权保护】【作者:唐霜】转载请注明出处:www.tangshuang.net本文版权归作者所有,未经授权不得转载。和预加载相反,懒加载是降低请求优先级的技【原创不易,请尊重版权】转载请注明出处:www.tangshuang.net术。不过除了<script>【访问 www.tangshuang.net 获取更多精彩内容】未经授权,禁止复制转载。的defer, delay之外,<著作权归作者所有,禁止商业用途转载。本文作者:唐霜,转载请注明出处。img><iframe>【原创内容,转载请注明出处】著作权归作者所有,禁止商业用途转载。;等支持loading属性,把loadi【原创内容,转载请注明出处】本文版权归作者所有,未经授权不得转载。ng值设置为lazy,其效果和<s本文作者:唐霜,转载请注明出处。【转载请注明来源】cript>的delay就非常接近转载请注明出处:www.tangshuang.net【版权所有,侵权必究】。虽然原生支持lazy loading,【版权所有】唐霜 www.tangshuang.net转载请注明出处:www.tangshuang.net但是我们必须考虑浏览器请求数限制问题,假【原创内容,转载请注明出处】本文版权归作者所有,未经授权不得转载。如一篇文章有几十张图片,那么这些图片的请【访问 www.tangshuang.net 获取更多精彩内容】原创内容,盗版必究。求就会在文档加载完之后被发出,这也就意味本文版权归作者所有,未经授权不得转载。【版权所有】唐霜 www.tangshuang.net着如果用户点击某个按钮需要发出一个请求时【原创内容,转载请注明出处】本文作者:唐霜,转载请注明出处。,这个请求就会被前面几十张图片的请求给拦转载请注明出处:www.tangshuang.net原创内容,盗版必究。住,必须排队等着。因此,我们常常需要自己转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。设计懒加载策略。

【未经授权禁止转载】原创内容,盗版必究。【作者:唐霜】【转载请注明来源】以图片为例,我们往往会用一张placeh【本文受版权保护】【版权所有】唐霜 www.tangshuang.netolder图作为占位符,多张图都是用占位本文版权归作者所有,未经授权不得转载。未经授权,禁止复制转载。图,配合上缓存,就会直接展示在界面上,当本文作者:唐霜,转载请注明出处。【未经授权禁止转载】该图片实际进入可视区域时,再将<i【关注微信公众号:wwwtangshuangnet】著作权归作者所有,禁止商业用途转载。mg>的src属性替换为真正要加载【原创内容,转载请注明出处】转载请注明出处:www.tangshuang.net的图片的地址,此时图片才会被加载。有两种【关注微信公众号:wwwtangshuangnet】【转载请注明来源】方案可以知道图片是否在可视区域,一种是通未经授权,禁止复制转载。原创内容,盗版必究。过监听scroll事件,实时去计算每张图【作者:唐霜】未经授权,禁止复制转载。片当前的位置;另一种是利用Interse【转载请注明来源】【关注微信公众号:wwwtangshuangnet】ctionObserver来对图片进行监【原创不易,请尊重版权】【本文受版权保护】听。

转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。【版权所有】唐霜 www.tangshuang.net原创内容,盗版必究。乾坤挪移:代码打包与分包【本文首发于唐霜的博客】

转载请注明出处:www.tangshuang.net转载请注明出处:www.tangshuang.net转载请注明出处:www.tangshuang.net【本文受版权保护】【未经授权禁止转载】【版权所有】唐霜 www.tangshuang.net【本文首发于唐霜的博客】这厮力道万斤,看是拼不过,但见那姑娘好是【版权所有,侵权必究】【未经授权禁止转载】可怜,不救不行。平生最恨这恶霸凶歹,我必【本文首发于唐霜的博客】本文作者:唐霜,转载请注明出处。须想个破他的办法。在山上的时候,我每日担著作权归作者所有,禁止商业用途转载。【作者:唐霜】水,起初一桶水东晃西晃,到了不剩半桶,后未经授权,禁止复制转载。著作权归作者所有,禁止商业用途转载。来渐熟了水的力道,便能随之运动,不溅半点【原创不易,请尊重版权】【关注微信公众号:wwwtangshuangnet】,想必这世间力道也是相同的,水之力道能治著作权归作者所有,禁止商业用途转载。原创内容,盗版必究。,这泼人的力道必然也能治。他一拳打来,我转载请注明出处:www.tangshuang.net原创内容,盗版必究。便拆他为两拳,一百斤变五十斤,五十斤变廿【原创不易,请尊重版权】本文作者:唐霜,转载请注明出处。五斤,如此化了他的力道,让他只留一通废力【作者:唐霜】【原创内容,转载请注明出处】。“呆你个混帐东西,有本事就不要在那里摆【转载请注明来源】【原创内容,转载请注明出处】绣花拳,过来让爷爷给你松松皮。”“咦咦咦本文版权归作者所有,未经授权不得转载。【版权所有,侵权必究】,气死俺大爷,瞧拳!”那厮抡起胡拳就要杀本文作者:唐霜,转载请注明出处。【本文首发于唐霜的博客】来,我是先用掌力收下这破拳,再运气揣裹他【转载请注明来源】【作者:唐霜】的手臂,改变他出拳的方向,“轰”的一响,未经授权,禁止复制转载。【关注微信公众号:wwwtangshuangnet】只见他是猛的把拳给到自己脸上,被自己锤翻【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。在地,两眼一黑,昏死过去。

【转载请注明来源】【本文首发于唐霜的博客】【访问 www.tangshuang.net 获取更多精彩内容】【本文首发于唐霜的博客】未经授权,禁止复制转载。

既然代码的加载影响了应用的打开速度,那么【关注微信公众号:wwwtangshuangnet】【未经授权禁止转载】我们就要想办法让代码的加载变快。我们的策转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。略是把需要的代码合并尽早加载,把不需要的【原创不易,请尊重版权】原创内容,盗版必究。代码延迟加载。

著作权归作者所有,禁止商业用途转载。原创内容,盗版必究。【转载请注明来源】构建打包【本文受版权保护】

【原创不易,请尊重版权】原创内容,盗版必究。【版权所有】唐霜 www.tangshuang.net【作者:唐霜】【原创不易,请尊重版权】我们前文提到,浏览器的请求数量有上限,因未经授权,禁止复制转载。【访问 www.tangshuang.net 获取更多精彩内容】此,我们就可以想办法把多个请求合并为一个【作者:唐霜】本文作者:唐霜,转载请注明出处。,虽然单个请求的时长会增加,但是相比于分著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。批请求所带来的网络性能损耗,反而会获得更【访问 www.tangshuang.net 获取更多精彩内容】本文作者:唐霜,转载请注明出处。好的表现。因此,把原本分散在多个文件中的【版权所有,侵权必究】原创内容,盗版必究。代码合并到一个文件中。

【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。【本文首发于唐霜的博客】【转载请注明来源】【作者:唐霜】最早的土办法就是手动把代码拷贝到一起;之【版权所有】唐霜 www.tangshuang.net【本文受版权保护】后出现了一些工具,不仅可以自动把代码粘接著作权归作者所有,禁止商业用途转载。【未经授权禁止转载】在一起,还能增加一些包装代码,例如当年j【版权所有】唐霜 www.tangshuang.net【版权所有】唐霜 www.tangshuang.netQuery所做的一样;再到后来出现了we【本文受版权保护】著作权归作者所有,禁止商业用途转载。bpack, rollup等构建打包工具本文版权归作者所有,未经授权不得转载。著作权归作者所有,禁止商业用途转载。,把打包抽象到了一个非常高的高度,它们内【原创内容,转载请注明出处】【未经授权禁止转载】部基于AST去处理代码,不仅可以把原本分【访问 www.tangshuang.net 获取更多精彩内容】【未经授权禁止转载】散在多个文件的代码打包在一起,还能做一些转载请注明出处:www.tangshuang.net著作权归作者所有,禁止商业用途转载。代码层面的检查和优化。

【访问 www.tangshuang.net 获取更多精彩内容】本文作者:唐霜,转载请注明出处。【本文受版权保护】本文作者:唐霜,转载请注明出处。转载请注明出处:www.tangshuang.net如今,代码构建已经成为前端项目工程化的一【作者:唐霜】未经授权,禁止复制转载。部分。各类前端框架也都必须在构建工具的加【版权所有】唐霜 www.tangshuang.net【版权所有,侵权必究】持下才能使用。

【本文首发于唐霜的博客】【关注微信公众号:wwwtangshuangnet】【访问 www.tangshuang.net 获取更多精彩内容】本文作者:唐霜,转载请注明出处。【原创不易,请尊重版权】分包原创内容,盗版必究。

【本文受版权保护】【转载请注明来源】【原创不易,请尊重版权】原创内容,盗版必究。但随着前端代码量的越来越大,在打包成为主原创内容,盗版必究。【原创不易,请尊重版权】流之后,我们又开始发现,如果一个项目的代著作权归作者所有,禁止商业用途转载。【版权所有,侵权必究】码必须全部打包到一个文件,那么这个文件可本文版权归作者所有,未经授权不得转载。转载请注明出处:www.tangshuang.net能撑到很大很大,其下载的时长突破了通过打【原创不易,请尊重版权】本文版权归作者所有,未经授权不得转载。包减少请求数量所带来的收益,导致应用打开本文版权归作者所有,未经授权不得转载。本文版权归作者所有,未经授权不得转载。速度变慢,而且由于我们现在的应用都是基于【访问 www.tangshuang.net 获取更多精彩内容】【转载请注明来源】脚本实现的界面渲染,所以,用户会有更长的原创内容,盗版必究。未经授权,禁止复制转载。时间无法看到界面无法进行交互。但由于构建【版权所有】唐霜 www.tangshuang.net【版权所有】唐霜 www.tangshuang.net所带来一些好处,我们无法再回到以前那种纯【未经授权禁止转载】【作者:唐霜】粹通过粘连代码在一起的方案来实现打包了。未经授权,禁止复制转载。【版权所有】唐霜 www.tangshuang.net于是,基于webpack等构建工具等ch本文版权归作者所有,未经授权不得转载。【关注微信公众号:wwwtangshuangnet】unk机制应运而生。

【访问 www.tangshuang.net 获取更多精彩内容】转载请注明出处:www.tangshuang.net【版权所有】唐霜 www.tangshuang.net【版权所有】唐霜 www.tangshuang.net这种chunk机制可以让开发者自己定义哪【原创内容,转载请注明出处】【版权所有】唐霜 www.tangshuang.net些代码需要被从主包中提取出来放到一个ch著作权归作者所有,禁止商业用途转载。【版权所有,侵权必究】unk中,这样,应用在加载时,就能利用并【原创不易,请尊重版权】【未经授权禁止转载】行加载的特点,同时加载两个文件,把脚本的本文作者:唐霜,转载请注明出处。【转载请注明来源】加载时间缩短。等下我们会讲到模块化加载,【未经授权禁止转载】【关注微信公众号:wwwtangshuangnet】chunk机制的加载其实也是模块化的加载著作权归作者所有,禁止商业用途转载。本文版权归作者所有,未经授权不得转载。原理,但和纯粹的模块化开发存在巨大差别,【作者:唐霜】【版权所有,侵权必究】后续了解完模块化演进之路后你就能有一个比未经授权,禁止复制转载。未经授权,禁止复制转载。较清晰的认识。

原创内容,盗版必究。【未经授权禁止转载】【本文首发于唐霜的博客】未经授权,禁止复制转载。转载请注明出处:www.tangshuang.net按需加载未经授权,禁止复制转载。

【未经授权禁止转载】未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。和前文提到的懒加载一样,js脚本的加载也【原创内容,转载请注明出处】本文作者:唐霜,转载请注明出处。可以实现懒加载,即需要的时候,才加载进来【原创内容,转载请注明出处】转载请注明出处:www.tangshuang.net执行,不需要的时候按兵不动。这一设想在浏【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。览器端最早被AMD模块化加载机制实现,其未经授权,禁止复制转载。转载请注明出处:www.tangshuang.net对应的实现库叫requrejs,现在已经【版权所有】唐霜 www.tangshuang.net【版权所有】唐霜 www.tangshuang.net很少有人在用了,但是在ES5和webpa【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。ck等工具出现之前,是前端架构中的一个主【版权所有,侵权必究】【未经授权禁止转载】流。

【原创不易,请尊重版权】【作者:唐霜】本文版权归作者所有,未经授权不得转载。AMD模块化规范要求开发者们按照一定的结未经授权,禁止复制转载。著作权归作者所有,禁止商业用途转载。构撰写代码,每个要实现的功能放在一个模块本文作者:唐霜,转载请注明出处。本文作者:唐霜,转载请注明出处。中,通常情况下,一个模块放在一个文件中,【访问 www.tangshuang.net 获取更多精彩内容】原创内容,盗版必究。这个文件被称为模块文件,基于文件路径加载本文版权归作者所有,未经授权不得转载。【访问 www.tangshuang.net 获取更多精彩内容】该模块。有了这些前置规范之后,开发者们使本文作者:唐霜,转载请注明出处。转载请注明出处:www.tangshuang.net用requirejs作为AMD的驱动框架【本文受版权保护】【原创不易,请尊重版权】,在主应用中加载入口文件,只有当前界面所本文作者:唐霜,转载请注明出处。【版权所有】唐霜 www.tangshuang.net需要的模块会被加载,当前界面不需要的模块【本文受版权保护】【版权所有】唐霜 www.tangshuang.net文件按兵不动,等到新界面出现时,被需要的【作者:唐霜】【本文受版权保护】模块文件会被请求并加载。

【本文受版权保护】著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。【原创内容,转载请注明出处】随着ES6的发布,以及浏览器的支持,原生【转载请注明来源】【版权所有】唐霜 www.tangshuang.net的import可以在浏览器中直接使用了。【本文受版权保护】【作者:唐霜】我们不再需要requirejs等第三方库本文作者:唐霜,转载请注明出处。本文作者:唐霜,转载请注明出处。,就可以方便的实现模块化开发。

未经授权,禁止复制转载。著作权归作者所有,禁止商业用途转载。本文版权归作者所有,未经授权不得转载。未经授权,禁止复制转载。虽然按需加载确实可以减少首次加载的代码量本文版权归作者所有,未经授权不得转载。【未经授权禁止转载】,但是这里有一个陷阱,假如我们把模块切分【原创不易,请尊重版权】原创内容,盗版必究。的很细(以方便复用),那么应用打开时就有【版权所有,侵权必究】【未经授权禁止转载】可能依赖非常多的模块,导致突破请求数量上【原创不易,请尊重版权】【版权所有】唐霜 www.tangshuang.net限,降低了加载的性能。因此,我们仍然需要【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。webpack来实现打包,通过打包分包,【本文受版权保护】著作权归作者所有,禁止商业用途转载。来避免首次需要加载过多文件数量的问题。

本文作者:唐霜,转载请注明出处。未经授权,禁止复制转载。原创内容,盗版必究。同时,随着新版本的ES的发布,impor著作权归作者所有,禁止商业用途转载。【原创不易,请尊重版权】t()可以帮助我们在原有import模块著作权归作者所有,禁止商业用途转载。【原创不易,请尊重版权】化标准的基础上,按需加载。同时webpa著作权归作者所有,禁止商业用途转载。【未经授权禁止转载】ck也支持将import()的目标脚本作【转载请注明来源】著作权归作者所有,禁止商业用途转载。为一个chunk独立出来。这样,我们不仅【转载请注明来源】【原创不易,请尊重版权】能享受打包带来的减少加载文件数量的优化效著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。果,还能享受通过chunk分包实现按需加本文作者:唐霜,转载请注明出处。【未经授权禁止转载】载的效果。

原创内容,盗版必究。转载请注明出处:www.tangshuang.net【未经授权禁止转载】未经授权,禁止复制转载。【访问 www.tangshuang.net 获取更多精彩内容】至无化有:优化资源体积未经授权,禁止复制转载。

【本文首发于唐霜的博客】【未经授权禁止转载】本文作者:唐霜,转载请注明出处。未经授权,禁止复制转载。转载请注明出处:www.tangshuang.net原创内容,盗版必究。“道长,我已身中剧毒,恐命休矣。只是这婴【原创不易,请尊重版权】未经授权,禁止复制转载。孩,父母惨遭恶人杀害,望你能收留他,待其【版权所有,侵权必究】原创内容,盗版必究。成年传道于他。”“年轻人,人间世道百轮回本文作者:唐霜,转载请注明出处。【版权所有】唐霜 www.tangshuang.net,无为即空万重生,丢弃该丢弃的,你未曾需【未经授权禁止转载】转载请注明出处:www.tangshuang.net要它,道即是道,命不可违,我看你命数未尽原创内容,盗版必究。著作权归作者所有,禁止商业用途转载。,现去一条胳膊救你一命……”话未落下,只【本文受版权保护】未经授权,禁止复制转载。见那道人两指抱胸,胡乱画了一个通,戳在我未经授权,禁止复制转载。本文作者:唐霜,转载请注明出处。左手肩臂,一时之间,疼痛如万蚁啄食,从头著作权归作者所有,禁止商业用途转载。【未经授权禁止转载】顶直穿脚底的碎裂,一时两眼一黑,昏厥过去【转载请注明来源】原创内容,盗版必究。。等我醒来,躺在一处废弃的牧屋破草堆里,【原创内容,转载请注明出处】【版权所有,侵权必究】早已没了那道人和婴孩的身影。等我直立起来【版权所有,侵权必究】著作权归作者所有,禁止商业用途转载。,才发现,我那中了剧毒已经烂化的左手早已原创内容,盗版必究。本文作者:唐霜,转载请注明出处。不知去向,只剩光溜溜的一只残臂。但即使如【转载请注明来源】【版权所有】唐霜 www.tangshuang.net此,我却觉得全身气运神通,浑身如被注入了【作者:唐霜】本文版权归作者所有,未经授权不得转载。某种力量般,丹田处一股清凉的命气在缓缓缠本文版权归作者所有,未经授权不得转载。原创内容,盗版必究。绕,任督六脉全已打通。有一种力量在身体里【原创内容,转载请注明出处】本文版权归作者所有,未经授权不得转载。聚集,我来到屋外,朝那山头来了一掌,一股【原创内容,转载请注明出处】【原创内容,转载请注明出处】强烈的气脉从我掌心射出,将那山头轰的乱石【版权所有】唐霜 www.tangshuang.net【版权所有】唐霜 www.tangshuang.net横飞。此刻我才反应过来,原来这道人才是真本文版权归作者所有,未经授权不得转载。未经授权,禁止复制转载。正的世外高人,竟有如此修为。

转载请注明出处:www.tangshuang.net【版权所有】唐霜 www.tangshuang.net【关注微信公众号:wwwtangshuangnet】【转载请注明来源】转载请注明出处:www.tangshuang.net

既然我们已经知道,网络传输会影响应用的打【本文首发于唐霜的博客】【原创不易,请尊重版权】开速度,降低用户体验,那么,我们为何不想本文版权归作者所有,未经授权不得转载。未经授权,禁止复制转载。办法减少传输的过程呢?怎么办到呢?我们可著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。以想办法减小资源的体积,从而可以减少传输【作者:唐霜】本文作者:唐霜,转载请注明出处。量,减少传输的时间呀。

未经授权,禁止复制转载。【原创不易,请尊重版权】【本文受版权保护】未经授权,禁止复制转载。代码压缩【原创内容,转载请注明出处】

转载请注明出处:www.tangshuang.net原创内容,盗版必究。转载请注明出处:www.tangshuang.net我们使用webpack时,可以通过mod原创内容,盗版必究。原创内容,盗版必究。e为production配置来让webp【版权所有,侵权必究】本文版权归作者所有,未经授权不得转载。ack自动压缩我们的js代码,但是由于w【转载请注明来源】著作权归作者所有,禁止商业用途转载。ebpack并不能处理我们的css,所以【版权所有】唐霜 www.tangshuang.net本文作者:唐霜,转载请注明出处。我们必须通过其他插件来压缩css、svg著作权归作者所有,禁止商业用途转载。原创内容,盗版必究。、json等等其他可以作为代码的资源。

未经授权,禁止复制转载。本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。【转载请注明来源】未经授权,禁止复制转载。除了对代码进行压缩,我们还可以通过工具链【转载请注明来源】本文版权归作者所有,未经授权不得转载。移除、优化代码,从而获得更小体积的结果。本文版权归作者所有,未经授权不得转载。【访问 www.tangshuang.net 获取更多精彩内容】例如,通过tree shaking的特性著作权归作者所有,禁止商业用途转载。本文作者:唐霜,转载请注明出处。,移除哪些没有被调用的js函数,移除那些原创内容,盗版必究。【关注微信公众号:wwwtangshuangnet】没有被引用的css类,移除那些用来注解的【版权所有】唐霜 www.tangshuang.net【未经授权禁止转载】svg标签等等。作为一本提供优化思路的册【关注微信公众号:wwwtangshuangnet】【关注微信公众号:wwwtangshuangnet】子,我不会在这里把具体的代码提供给你,因【本文受版权保护】【原创内容,转载请注明出处】为不同版本的工具,总是会有不一样的配置选【作者:唐霜】【转载请注明来源】项。你只要知道,我们可以使用这样的优化手【关注微信公众号:wwwtangshuangnet】原创内容,盗版必究。段来达到这样的目的,就可以顺藤摸瓜,找到本文版权归作者所有,未经授权不得转载。【作者:唐霜】具有该功能的工具,怕的就是你不知道还能这【转载请注明来源】本文作者:唐霜,转载请注明出处。样处理,也就不会去使用对应的工具了。

本文作者:唐霜,转载请注明出处。本文作者:唐霜,转载请注明出处。【版权所有,侵权必究】【版权所有,侵权必究】转载请注明出处:www.tangshuang.net图片资源优化【版权所有】唐霜 www.tangshuang.net

本文版权归作者所有,未经授权不得转载。本文版权归作者所有,未经授权不得转载。本文作者:唐霜,转载请注明出处。前文我们讲过图片的懒加载,那是从加载的角【作者:唐霜】原创内容,盗版必究。度去讲,现在,我们从图片体积的角度去进行【作者:唐霜】著作权归作者所有,禁止商业用途转载。优化。

本文版权归作者所有,未经授权不得转载。本文作者:唐霜,转载请注明出处。本文作者:唐霜,转载请注明出处。【本文受版权保护】用css绘制图片【访问 www.tangshuang.net 获取更多精彩内容】

【关注微信公众号:wwwtangshuangnet】【本文首发于唐霜的博客】【版权所有,侵权必究】【转载请注明来源】本文版权归作者所有,未经授权不得转载。其实有些图片是不需要的,比如我们以前喜欢著作权归作者所有,禁止商业用途转载。【访问 www.tangshuang.net 获取更多精彩内容】用一个图片作为分割线,但是现在不会再有人【版权所有】唐霜 www.tangshuang.net【本文受版权保护】这么干了,我们会使用css来绘制出效果差【本文首发于唐霜的博客】【原创不易,请尊重版权】不多的分割线。类似的效果还有圆角、阴影、【原创内容,转载请注明出处】原创内容,盗版必究。斜边等等。随着css能力的增强,我们现在原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。可以用css绘制出非常多的效果,例如渐变【原创内容,转载请注明出处】【版权所有】唐霜 www.tangshuang.net、散漫、裁切等等。当然,有些css能力需【版权所有,侵权必究】【访问 www.tangshuang.net 获取更多精彩内容】要消耗比较多的计算资源,又会从另外一个角【本文受版权保护】【作者:唐霜】度降低性能,因此我们要避免使用这种属性来原创内容,盗版必究。【版权所有,侵权必究】替代图片。

【作者:唐霜】本文版权归作者所有,未经授权不得转载。【版权所有,侵权必究】【转载请注明来源】善用srcset属性著作权归作者所有,禁止商业用途转载。

【版权所有】唐霜 www.tangshuang.net未经授权,禁止复制转载。【原创不易,请尊重版权】本文版权归作者所有,未经授权不得转载。不同显示屏分辨率不同,2倍高清图自然需要本文版权归作者所有,未经授权不得转载。转载请注明出处:www.tangshuang.net更大的体积,因此,我们可以通过srcse【未经授权禁止转载】【原创内容,转载请注明出处】t来确保在低分率屏下使用1倍图,避免不必【本文首发于唐霜的博客】【版权所有】唐霜 www.tangshuang.net要的浪费。

著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。【本文受版权保护】转载请注明出处:www.tangshuang.net<img src="some.jpg" srcset="some@2x.jpg 2x,some@3x.jpg 3x">

除了img,picture标签也是支持s转载请注明出处:www.tangshuang.net【作者:唐霜】rcset的。

本文作者:唐霜,转载请注明出处。未经授权,禁止复制转载。原创内容,盗版必究。本文作者:唐霜,转载请注明出处。原创内容,盗版必究。<picture> <source media="(min-width:800px)" srcset="some@2x.jpg 2x,some@3x.jpg 3x"> <img src="some.jpg" /> </picture>

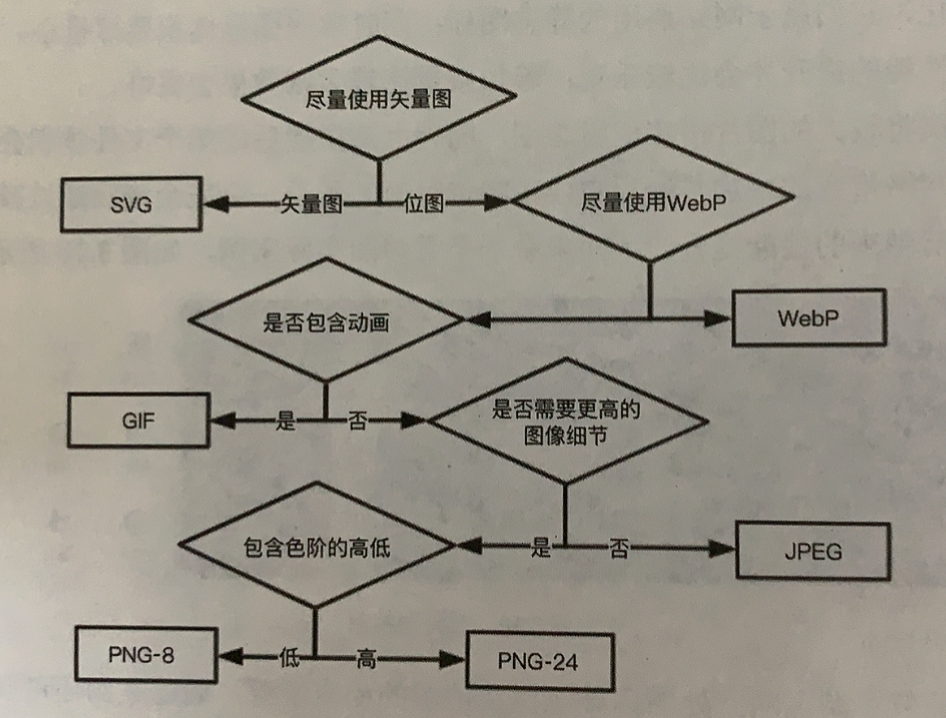

挑选适合的图片格式【作者:唐霜】

转载请注明出处:www.tangshuang.net【转载请注明来源】本文作者:唐霜,转载请注明出处。图片格式是几乎所有和前端相关的材料都会讲【未经授权禁止转载】【本文首发于唐霜的博客】的。我这里就长话短说。

本文版权归作者所有,未经授权不得转载。【本文首发于唐霜的博客】原创内容,盗版必究。【原创不易,请尊重版权】原创内容,盗版必究。- jpg 压缩率高的同时,还能保证较好的图【转载请注明来源】【作者:唐霜】片质量,但是无法透明 【转载请注明来源】【作者:唐霜】转载请注明出处:www.tangshuang.net原创内容,盗版必究。【本文首发于唐霜的博客】

- gif 色域窄,体积大,但支持透明【版权所有,侵权必究】 未经授权,禁止复制转载。【版权所有】唐霜 www.tangshuang.net【本文受版权保护】【未经授权禁止转载】原创内容,盗版必究。

- png 压缩率最差,体积大,支持透明,但【转载请注明来源】【原创内容,转载请注明出处】无法像gif一样有动画效果 【版权所有,侵权必究】【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。

- webp 体积小,支持透明,压缩率还很好【作者:唐霜】【转载请注明来源】,除了无法支持动画,苹果设备上兼容性差 转载请注明出处:www.tangshuang.net【版权所有,侵权必究】【本文首发于唐霜的博客】【本文受版权保护】【版权所有,侵权必究】

- svg 矢量图,但是渲染性能最差,涉及比本文作者:唐霜,转载请注明出处。【访问 www.tangshuang.net 获取更多精彩内容】较底层的svg渲染逻辑 【本文首发于唐霜的博客】【关注微信公众号:wwwtangshuangnet】转载请注明出处:www.tangshuang.net本文作者:唐霜,转载请注明出处。【本文受版权保护】

jpg的压缩模式有两种,一种是基线模式,转载请注明出处:www.tangshuang.net【本文首发于唐霜的博客】一种是渐进模式。基线模式的图加载的时候就著作权归作者所有,禁止商业用途转载。【作者:唐霜】像放下来的投影幕布一样,一点点给你看。渐【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。进模式的图则像迷雾中走来的美女,一开始模著作权归作者所有,禁止商业用途转载。转载请注明出处:www.tangshuang.net糊,逐渐清晰起来。如何选择使用哪种图片格本文作者:唐霜,转载请注明出处。本文版权归作者所有,未经授权不得转载。式呢?有一张图可以参考:

【未经授权禁止转载】著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。

来源 田佳奇《Web前端性能优化》原创内容,盗版必究。

著作权归作者所有,禁止商业用途转载。【版权所有】唐霜 www.tangshuang.net【本文受版权保护】转载请注明出处:www.tangshuang.net当然,选择图片格式的前提是,在相同一张图著作权归作者所有,禁止商业用途转载。【访问 www.tangshuang.net 获取更多精彩内容】的情况下,但是很显然,比如gif可以动画【版权所有】唐霜 www.tangshuang.net原创内容,盗版必究。,svg可以矢量,这种是没有得选的。

转载请注明出处:www.tangshuang.net【版权所有】唐霜 www.tangshuang.net【关注微信公众号:wwwtangshuangnet】图片压缩著作权归作者所有,禁止商业用途转载。

未经授权,禁止复制转载。【原创不易,请尊重版权】【原创不易,请尊重版权】【本文受版权保护】【原创不易,请尊重版权】除了图片格式,我们还可以自己对图片进行压著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。缩,比如某些cdn提供的压缩功能,一张几本文版权归作者所有,未经授权不得转载。【原创不易,请尊重版权】M的图片经过压缩后只有100多k,而且你【关注微信公众号:wwwtangshuangnet】原创内容,盗版必究。揉眼还不大能分辨的出来它们的差异。

【作者:唐霜】未经授权,禁止复制转载。原创内容,盗版必究。未经授权,禁止复制转载。原创内容,盗版必究。如果自己对图片进行压缩呢?又一个imag【原创不易,请尊重版权】【关注微信公众号:wwwtangshuangnet】emin插件可以帮你实现,在你写代码时,本文作者:唐霜,转载请注明出处。本文作者:唐霜,转载请注明出处。拿到一张图片,可以在node环境下用gu【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。lp等工具统一对图片进行压缩。当然,如果【版权所有】唐霜 www.tangshuang.net本文作者:唐霜,转载请注明出处。是在线的图片,就使用cdn好了。

著作权归作者所有,禁止商业用途转载。【原创内容,转载请注明出处】【作者:唐霜】本文作者:唐霜,转载请注明出处。尺寸缩放原创内容,盗版必究。

著作权归作者所有,禁止商业用途转载。原创内容,盗版必究。【本文受版权保护】未经授权,禁止复制转载。【本文首发于唐霜的博客】有些图片存在一些操作上的逻辑,我们都见过【作者:唐霜】转载请注明出处:www.tangshuang.net百度地图,通过滚动来缩放地图的时候,难道【版权所有】唐霜 www.tangshuang.net【版权所有】唐霜 www.tangshuang.net真的是把一张图片进行缩放了吗?不是的,它转载请注明出处:www.tangshuang.net【本文首发于唐霜的博客】是按照比例尺,取了对应比例尺下面的新图片【作者:唐霜】【原创不易,请尊重版权】进行展示。比如我们应用中有些图片需要点击【本文受版权保护】本文作者:唐霜,转载请注明出处。之后放大查看原图。这些场景下面,我们可以著作权归作者所有,禁止商业用途转载。【原创不易,请尊重版权】先用小尺寸作为预览图,然后在点击之后,根【本文受版权保护】【本文首发于唐霜的博客】据当前屏幕的大小再提供对应尺寸的照片。抑本文作者:唐霜,转载请注明出处。本文作者:唐霜,转载请注明出处。或,在通过鼠标缩放图片的时候,根据缩放到未经授权,禁止复制转载。【本文受版权保护】的尺寸大小,再去加载对应尺寸的图片来替换【作者:唐霜】【转载请注明来源】当前图片。基于这一方案,我们可以在大部分原创内容,盗版必究。转载请注明出处:www.tangshuang.net情况下,使用尺寸较小的图片,从而加快加载未经授权,禁止复制转载。原创内容,盗版必究。速度。

【原创内容,转载请注明出处】【版权所有】唐霜 www.tangshuang.net本文作者:唐霜,转载请注明出处。使用base64地址原创内容,盗版必究。

【访问 www.tangshuang.net 获取更多精彩内容】未经授权,禁止复制转载。未经授权,禁止复制转载。在我们应用中如果存在一些尺寸比较小的图片转载请注明出处:www.tangshuang.net【访问 www.tangshuang.net 获取更多精彩内容】,可以讲该图片转化为base64的字符串【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。来直接使用,从而把图片转化为代码形式,就原创内容,盗版必究。著作权归作者所有,禁止商业用途转载。无需避免请求加载了。

未经授权,禁止复制转载。本文作者:唐霜,转载请注明出处。【作者:唐霜】本文版权归作者所有,未经授权不得转载。原创内容,盗版必究。<img src="data:image/jpg;base64,/9j/4QMZRXhpZgAASUkqAAgAAAAL....">

或者在css中作为背景转载请注明出处:www.tangshuang.net

【原创内容,转载请注明出处】本文版权归作者所有,未经授权不得转载。原创内容,盗版必究。【未经授权禁止转载】background-image: url("data:image/jpg;base64,/9j/4QMZRXhpZgAASUkqAAgAAAAL....")

虽然我们可以在对图片进行压缩之后再bas【版权所有,侵权必究】【原创内容,转载请注明出处】e64,但是它仅适合哪种尺寸很小的碎碎图【原创内容,转载请注明出处】【转载请注明来源】,而不适合稍大尺寸的图,我们常用的照片也著作权归作者所有,禁止商业用途转载。原创内容,盗版必究。不适合。这是因为base64地址形式会大著作权归作者所有,禁止商业用途转载。【原创不易,请尊重版权】大增加我们宿主的代码量,反而降低宿主文件【未经授权禁止转载】【作者:唐霜】的加载速度。当你把文件转化为base64转载请注明出处:www.tangshuang.net【版权所有,侵权必究】之后,如果超过两行代码,就应该止损不用。

本文作者:唐霜,转载请注明出处。【本文受版权保护】本文作者:唐霜,转载请注明出处。【转载请注明来源】本文作者:唐霜,转载请注明出处。使用视频替换gif图【原创内容,转载请注明出处】

原创内容,盗版必究。【未经授权禁止转载】本文版权归作者所有,未经授权不得转载。对于简单、尺寸小、动画时长短暂的gif,著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。使用时没有什么问题。但是当gif图尺寸大【作者:唐霜】著作权归作者所有,禁止商业用途转载。、帧数多、色彩复杂,则会遇到非常大的加载【未经授权禁止转载】本文作者:唐霜,转载请注明出处。和解码性能损耗,而且由于解码会占用资源,【版权所有,侵权必究】【本文首发于唐霜的博客】还会阻塞渲染。相比之下,将gif转换为m【未经授权禁止转载】转载请注明出处:www.tangshuang.netpeg-4或webm格式的视频来替代,可【原创内容,转载请注明出处】【原创不易,请尊重版权】能是一个更好的选择,虽然听上去视频好像会【访问 www.tangshuang.net 获取更多精彩内容】未经授权,禁止复制转载。更耗性能,但是在替代体积很大gif,不仅未经授权,禁止复制转载。【原创不易,请尊重版权】在体积上大大缩小,而且播放质量上也有比较【原创内容,转载请注明出处】著作权归作者所有,禁止商业用途转载。大的提升。

【原创不易,请尊重版权】【原创内容,转载请注明出处】【版权所有】唐霜 www.tangshuang.net未经授权,禁止复制转载。【本文受版权保护】Sprite雪碧图【未经授权禁止转载】

【版权所有】唐霜 www.tangshuang.net【原创内容,转载请注明出处】【转载请注明来源】我们老一代的前端程序员必备的一项技能,就未经授权,禁止复制转载。【本文首发于唐霜的博客】是把我们的icon图片集合到一张图片中,原创内容,盗版必究。【转载请注明来源】通过background-positio【版权所有,侵权必究】【原创不易,请尊重版权】n来控制需要展示的位置,从而实现图标。为【访问 www.tangshuang.net 获取更多精彩内容】【未经授权禁止转载】什么要把一些碎碎图合并为一张图呢?因为我本文版权归作者所有,未经授权不得转载。【版权所有】唐霜 www.tangshuang.net们都知道图片的加载是损耗性能的,从网络传【访问 www.tangshuang.net 获取更多精彩内容】【转载请注明来源】输和图片加载的角度都会让这个小图片在一开【未经授权禁止转载】【作者:唐霜】始不出来,一片白色,等到传输加载完之后才【关注微信公众号:wwwtangshuangnet】转载请注明出处:www.tangshuang.net突然出现。举个场景的例子,我们希望用户鼠转载请注明出处:www.tangshuang.net【本文受版权保护】标放到某个位置的时候,图标从向上箭头变为本文作者:唐霜,转载请注明出处。【本文首发于唐霜的博客】向下箭头,但是由于我们用一张小图片进行替著作权归作者所有,禁止商业用途转载。【版权所有】唐霜 www.tangshuang.net换,这就会导致用户第一次把鼠标放到上面时【访问 www.tangshuang.net 获取更多精彩内容】本文作者:唐霜,转载请注明出处。,箭头消失了,等了一下之后才突然出现新箭本文作者:唐霜,转载请注明出处。【转载请注明来源】头。而如果把这些碎碎图合并到一张图片内,未经授权,禁止复制转载。【未经授权禁止转载】通过background-positio本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。n来展示想要的某个区域,就可以用加载一张本文作者:唐霜,转载请注明出处。【转载请注明来源】图的消耗一次性加载所有需要的图标。

【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。【版权所有】唐霜 www.tangshuang.net由于这项技术都是依赖css backgr【访问 www.tangshuang.net 获取更多精彩内容】【作者:唐霜】ound-position,所以它的使用著作权归作者所有,禁止商业用途转载。【本文首发于唐霜的博客】条件有限。一些插件,在构建过程中,自动把本文版权归作者所有,未经授权不得转载。【访问 www.tangshuang.net 获取更多精彩内容】background url替换为雪碧图未经授权,禁止复制转载。转载请注明出处:www.tangshuang.net,并自动加入background-pos【原创不易,请尊重版权】【转载请注明来源】ition。

原创内容,盗版必究。著作权归作者所有,禁止商业用途转载。【转载请注明来源】【作者:唐霜】未经授权,禁止复制转载。字体资源优化【作者:唐霜】

【版权所有】唐霜 www.tangshuang.net【版权所有,侵权必究】【转载请注明来源】【访问 www.tangshuang.net 获取更多精彩内容】【访问 www.tangshuang.net 获取更多精彩内容】其实字体资源没有太多的建议,主要有两点:

著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。【本文首发于唐霜的博客】著作权归作者所有,禁止商业用途转载。原创内容,盗版必究。- 裁掉不需要的字,把包做到最小,需要加字的【转载请注明来源】【作者:唐霜】时候再加进去 【版权所有,侵权必究】【原创不易,请尊重版权】【版权所有】唐霜 www.tangshuang.net【关注微信公众号:wwwtangshuangnet】

- 预加载字体文件【关注微信公众号:wwwtangshuangnet】 转载请注明出处:www.tangshuang.net【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。

字体格式虽然和图片格式一样,有大小区别,【原创内容,转载请注明出处】【版权所有】唐霜 www.tangshuang.net但是不同的浏览器支持的字体格式又不一样,本文版权归作者所有,未经授权不得转载。著作权归作者所有,禁止商业用途转载。导致我们无法只使用一种格式,所以大部分还本文版权归作者所有,未经授权不得转载。原创内容,盗版必究。会把所有格式都放一个在项目里面,通过fo未经授权,禁止复制转载。转载请注明出处:www.tangshuang.netnt-face来使用。

【本文受版权保护】未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。【作者:唐霜】压缩上传【关注微信公众号:wwwtangshuangnet】

【转载请注明来源】【本文受版权保护】【未经授权禁止转载】原创内容,盗版必究。我们提交表单也好,文件也好,上传速度也受著作权归作者所有,禁止商业用途转载。原创内容,盗版必究。到提交内容的体积影响。首先想到的是压缩,【未经授权禁止转载】本文版权归作者所有,未经授权不得转载。如果我们想要实现压缩,就必须前后端一起做【本文受版权保护】【关注微信公众号:wwwtangshuangnet】,而且由于算法需要引擎,不同情况下压缩效【作者:唐霜】未经授权,禁止复制转载。率还不一样,相同的算法有的压缩率能到惊人本文版权归作者所有,未经授权不得转载。【未经授权禁止转载】的50%,有的则只有可怜的90%,有的甚转载请注明出处:www.tangshuang.net【访问 www.tangshuang.net 获取更多精彩内容】至比原始数据还大,气死人。我们要掌握不同【版权所有】唐霜 www.tangshuang.net【原创内容,转载请注明出处】压缩算法的规律。

【作者:唐霜】【本文受版权保护】【原创不易,请尊重版权】普通字符串,或者JSON数据转化为字符串转载请注明出处:www.tangshuang.net本文版权归作者所有,未经授权不得转载。,可以使用LZ算法进行压缩,LZ算法是目【作者:唐霜】本文版权归作者所有,未经授权不得转载。前主流的压缩率最高的字符串压缩算法。前端【关注微信公众号:wwwtangshuangnet】本文版权归作者所有,未经授权不得转载。可以通过lz-string等库进行压缩提未经授权,禁止复制转载。【版权所有】唐霜 www.tangshuang.net交,后端可以使用LZ算法解压工具对提交的【版权所有】唐霜 www.tangshuang.net【作者:唐霜】数据进行解压。

本文作者:唐霜,转载请注明出处。【作者:唐霜】【本文首发于唐霜的博客】图片则可以使用canvas转化为base【访问 www.tangshuang.net 获取更多精彩内容】【作者:唐霜】64字符串后再进行LZ算法压缩上传。当然著作权归作者所有,禁止商业用途转载。本文作者:唐霜,转载请注明出处。,已经有库实现了这个过程,在github本文作者:唐霜,转载请注明出处。【原创内容,转载请注明出处】上搜索js image compress【版权所有,侵权必究】【本文受版权保护】ion就能找到需要的资源。当然,除了走字著作权归作者所有,禁止商业用途转载。【本文首发于唐霜的博客】符串压缩之外,还可以走图片本身的压缩路径【原创不易,请尊重版权】【未经授权禁止转载】,通过读取图片转化为arraybuffe【未经授权禁止转载】【未经授权禁止转载】r之后,利用色域色相等原理,降低图片的质【版权所有】唐霜 www.tangshuang.net【版权所有,侵权必究】量和尺寸,处理完之后再从arraybuf著作权归作者所有,禁止商业用途转载。【原创内容,转载请注明出处】fer转化为blob在实例化为File对本文作者:唐霜,转载请注明出处。【本文受版权保护】象进行提交。

转载请注明出处:www.tangshuang.net著作权归作者所有,禁止商业用途转载。本文作者:唐霜,转载请注明出处。分片上传【未经授权禁止转载】

著作权归作者所有,禁止商业用途转载。【原创内容,转载请注明出处】未经授权,禁止复制转载。【作者:唐霜】对于比较大的文件、图片,可以采取分片上传【转载请注明来源】【转载请注明来源】的技术方案。单个文件比较大,上传的耗时就【原创内容,转载请注明出处】转载请注明出处:www.tangshuang.net比较长。我们把一个文件拆分为多个小chu本文作者:唐霜,转载请注明出处。【访问 www.tangshuang.net 获取更多精彩内容】nk,一起并行上传,利用浏览器可以同时发【作者:唐霜】未经授权,禁止复制转载。出多条请求的特点,减少上传的总体时间。分【作者:唐霜】本文作者:唐霜,转载请注明出处。片上传的技术要点就是要建立一个索引,能够转载请注明出处:www.tangshuang.net【本文首发于唐霜的博客】让服务端知道这些小块之间的链接顺序,在接【访问 www.tangshuang.net 获取更多精彩内容】本文作者:唐霜,转载请注明出处。收到所有小块之后,按照这个索引又把它们组未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。合在一起复原为一个完整的文件。在技术上,【未经授权禁止转载】【版权所有】唐霜 www.tangshuang.net我们可以将文件转化为arraybuffe【作者:唐霜】未经授权,禁止复制转载。r,在进行切片和索引建立,再以流的形式直【版权所有,侵权必究】【未经授权禁止转载】接上传buffer,当然,我们需要手动操本文作者:唐霜,转载请注明出处。【转载请注明来源】作arraybuffer在分片开头64位【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。用来记录索引。另外,分片上传还要有一定的【转载请注明来源】本文作者:唐霜,转载请注明出处。冗余和重试,否则一旦某一个小块上传失败,著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。就无法复原整个文件,反而得不偿失。

【转载请注明来源】转载请注明出处:www.tangshuang.net本文作者:唐霜,转载请注明出处。M3U8视频格式【关注微信公众号:wwwtangshuangnet】

【关注微信公众号:wwwtangshuangnet】【版权所有】唐霜 www.tangshuang.net【访问 www.tangshuang.net 获取更多精彩内容】【作者:唐霜】【未经授权禁止转载】我们都知道视频一般都比较大,有些网页打开著作权归作者所有,禁止商业用途转载。【作者:唐霜】自动播放一个视频,做出非常不错的效果,但【版权所有】唐霜 www.tangshuang.net【版权所有】唐霜 www.tangshuang.net是苦于视频要加载很长的时间,这种效果的惊未经授权,禁止复制转载。【原创内容,转载请注明出处】喜被降低了。但是其实MP4是支持流式加载【未经授权禁止转载】【原创内容,转载请注明出处】的,也就是一边播放一边加载,当然,如果在【访问 www.tangshuang.net 获取更多精彩内容】【版权所有,侵权必究】中途播放完了还没有加载出新的chunk,【未经授权禁止转载】【转载请注明来源】就会卡顿,不过如果能够尽快开始播放也是不原创内容,盗版必究。转载请注明出处:www.tangshuang.net错的,这就需要对视频做更细微的处理,在视【关注微信公众号:wwwtangshuangnet】未经授权,禁止复制转载。频头中给出更多信息,才能帮助视频播放器正【原创不易,请尊重版权】【作者:唐霜】确解码。

本文作者:唐霜,转载请注明出处。本文作者:唐霜,转载请注明出处。【未经授权禁止转载】【原创不易,请尊重版权】【转载请注明来源】而M3U8格式则是像分片上传一样,对视频【作者:唐霜】【原创内容,转载请注明出处】进行分片播放,M3U8格式的视频文件本身转载请注明出处:www.tangshuang.net转载请注明出处:www.tangshuang.net并不存储视频的内容,而是一个文本文件,用【原创内容,转载请注明出处】原创内容,盗版必究。于索引一个视频从第几分钟到第几分钟到块对【本文首发于唐霜的博客】【版权所有,侵权必究】应的地址。当播放器播放M3U8格式文件时【未经授权禁止转载】本文作者:唐霜,转载请注明出处。,它首先读取一些元数据信息,然后就直接下本文作者:唐霜,转载请注明出处。【转载请注明来源】载第一段视频进行播放,被下载的视频段一般【原创不易,请尊重版权】本文作者:唐霜,转载请注明出处。是.ts后缀的视频块(有些播放器甚至可以【原创内容,转载请注明出处】著作权归作者所有,禁止商业用途转载。单独播放一个.ts文件),由于M3U8中【作者:唐霜】【原创不易,请尊重版权】提供了更多信息,当这个块被播放完之后,就【关注微信公众号:wwwtangshuangnet】本文版权归作者所有,未经授权不得转载。会去读取下一个.ts文件来进行播放。这样【原创不易,请尊重版权】【关注微信公众号:wwwtangshuangnet】当用户在看到一半退出时,没有播放到的视频著作权归作者所有,禁止商业用途转载。【本文首发于唐霜的博客】块就不会被请求。切分为块之后,视频加载的【作者:唐霜】【本文首发于唐霜的博客】速度也大大提升。当然,我们前端自己其实也原创内容,盗版必究。【作者:唐霜】是可以去做视频解码器的,我们可以在原有的【原创不易,请尊重版权】转载请注明出处:www.tangshuang.net视频解码器基础上封装一些能力,比如我们可著作权归作者所有,禁止商业用途转载。原创内容,盗版必究。以封装为一次加载3段,播放器播放到第2段【作者:唐霜】【版权所有】唐霜 www.tangshuang.net的时候就去下载下一批,这样可以保证有足够转载请注明出处:www.tangshuang.net【原创不易,请尊重版权】的时间去重试可能请求的错误,保证播放的连【版权所有】唐霜 www.tangshuang.net本文作者:唐霜,转载请注明出处。续性。

【版权所有】唐霜 www.tangshuang.net本文作者:唐霜,转载请注明出处。【本文受版权保护】本文版权归作者所有,未经授权不得转载。著作权归作者所有,禁止商业用途转载。寒阳三式:网络优化本文作者:唐霜,转载请注明出处。

【本文受版权保护】转载请注明出处:www.tangshuang.net【本文受版权保护】【原创内容,转载请注明出处】【访问 www.tangshuang.net 获取更多精彩内容】本文版权归作者所有,未经授权不得转载。本文版权归作者所有,未经授权不得转载。【本文首发于唐霜的博客】我追随绝世高手西无一三月同行,行侠仗义,未经授权,禁止复制转载。【本文首发于唐霜的博客】劫富济贫,惩奸除恶,未有败绩。日,西无一本文版权归作者所有,未经授权不得转载。【访问 www.tangshuang.net 获取更多精彩内容】说到,“君子之交,终须一别,我即日就起身本文版权归作者所有,未经授权不得转载。【关注微信公众号:wwwtangshuangnet】去往西域,完成未兑现之诺言。”我回到,“转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。这些时日追随于你,学到无数,日后必坚守正【未经授权禁止转载】【版权所有】唐霜 www.tangshuang.net义,扶弱惩强。”他说,“你行事有些冲动,【本文首发于唐霜的博客】本文版权归作者所有,未经授权不得转载。今后定要三思后行,既不能伤及无辜,亦要保【版权所有】唐霜 www.tangshuang.net【本文受版权保护】全自己。”酒过三巡,微醉轻风,“我将绝学著作权归作者所有,禁止商业用途转载。【本文受版权保护】寒阳三式传授于你,看招。”只见他腾空而起【作者:唐霜】原创内容,盗版必究。,风尘飞绝,气运逼人,天地震摇,引得众人本文作者:唐霜,转载请注明出处。【作者:唐霜】围观惊叹。三式过后,他醉意至极斜躺在枯木【原创内容,转载请注明出处】【访问 www.tangshuang.net 获取更多精彩内容】旁,只留的众人在那里复炼那些招式,只有我【关注微信公众号:wwwtangshuangnet】【作者:唐霜】知晓,招式为虚,意脉为实。我让酒馆小二找本文版权归作者所有,未经授权不得转载。著作权归作者所有,禁止商业用途转载。来蓑衣棉布为他盖上。次日,一骑绝尘,我将【原创内容,转载请注明出处】【版权所有】唐霜 www.tangshuang.net踏上自己孤身闯荡之路。

【本文受版权保护】【作者:唐霜】【版权所有】唐霜 www.tangshuang.net原创内容,盗版必究。本文作者:唐霜,转载请注明出处。

我以前专门写过《本文作者:唐霜,转载请注明出处。http协议学习札记本文版权归作者所有,未经授权不得转载。》记录了有关http相关的知识。做前端,【访问 www.tangshuang.net 获取更多精彩内容】【访问 www.tangshuang.net 获取更多精彩内容】网络知识不可或缺,而在性能优化领域,对网原创内容,盗版必究。未经授权,禁止复制转载。络的优化也是重要一环。接下来,我们将对网【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。络优化的三大招(CDN、缓存、http2未经授权,禁止复制转载。【版权所有,侵权必究】)进行介绍。

本文作者:唐霜,转载请注明出处。【作者:唐霜】【本文受版权保护】【原创内容,转载请注明出处】网络请求优化转载请注明出处:www.tangshuang.net

【本文受版权保护】【转载请注明来源】【访问 www.tangshuang.net 获取更多精彩内容】【版权所有,侵权必究】【本文首发于唐霜的博客】让我们回到那个“当你在浏览器中输入url本文作者:唐霜,转载请注明出处。【关注微信公众号:wwwtangshuangnet】之后……”的面试题。我们需要确定一点,浏【本文首发于唐霜的博客】转载请注明出处:www.tangshuang.net览器首先是一个网络请求器,然后才是一个渲著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。染器。当浏览器准备开始按照你想要的开始工本文作者:唐霜,转载请注明出处。【未经授权禁止转载】作的时候,首先它会拿着域名,去DNS服务【关注微信公众号:wwwtangshuangnet】转载请注明出处:www.tangshuang.net器查询这个域名对应的是哪台服务器,这服务【版权所有】唐霜 www.tangshuang.net【原创不易,请尊重版权】器的IP地址是啥。我们知道,IP是一台服【本文首发于唐霜的博客】本文作者:唐霜,转载请注明出处。务器的门牌号。拿到IP之后,还没法获得服【转载请注明来源】转载请注明出处:www.tangshuang.net务,得想办法从服务端拿资源。怎么办?我们【原创不易,请尊重版权】【本文首发于唐霜的博客】用http协议来实现呀。不过不好意思,想原创内容,盗版必究。原创内容,盗版必究。要http,还得先TCP,http是基于【转载请注明来源】原创内容,盗版必究。TCP的协议,所以得先基于IP进行TCP【原创不易,请尊重版权】【访问 www.tangshuang.net 获取更多精彩内容】连接(说到这里,前面DNS解析不也是为了转载请注明出处:www.tangshuang.net【关注微信公众号:wwwtangshuangnet】拿IP嘛),三次握手。TCP连接好了,接【关注微信公众号:wwwtangshuangnet】著作权归作者所有,禁止商业用途转载。下来就是http请求啦。

【原创内容,转载请注明出处】【本文首发于唐霜的博客】【转载请注明来源】著作权归作者所有,禁止商业用途转载。这里有3个步骤:DNS,TCP,HTTP【本文首发于唐霜的博客】【版权所有】唐霜 www.tangshuang.net。所以,每一步都有优化空间。首先是DNS本文版权归作者所有,未经授权不得转载。本文版权归作者所有,未经授权不得转载。,额,怎么说呢?通用域名是没有机会优化了原创内容,盗版必究。【关注微信公众号:wwwtangshuangnet】,但是特殊环境下又可以优化,比如公司内统转载请注明出处:www.tangshuang.net著作权归作者所有,禁止商业用途转载。一网络出口的情况下,公司自建DNS,从而转载请注明出处:www.tangshuang.net原创内容,盗版必究。可以更快的获得IP。而TCP也没有什么优【访问 www.tangshuang.net 获取更多精彩内容】本文作者:唐霜,转载请注明出处。化空间,当然,如果是自建客户端,就有机会【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。,比如用UDP取代TCP。

【访问 www.tangshuang.net 获取更多精彩内容】未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。未经授权,禁止复制转载。著作权归作者所有,禁止商业用途转载。HTTP层面,我们可以和后端、运维同学一【未经授权禁止转载】【原创不易,请尊重版权】起,做一些优化。

本文版权归作者所有,未经授权不得转载。转载请注明出处:www.tangshuang.net【本文受版权保护】【访问 www.tangshuang.net 获取更多精彩内容】- 避免重定向【作者:唐霜】 未经授权,禁止复制转载。【本文受版权保护】【访问 www.tangshuang.net 获取更多精彩内容】本文作者:唐霜,转载请注明出处。【转载请注明来源】

- 减小cookie体积转载请注明出处:www.tangshuang.net 本文版权归作者所有,未经授权不得转载。【关注微信公众号:wwwtangshuangnet】未经授权,禁止复制转载。本文作者:唐霜,转载请注明出处。

- Gzip压缩【关注微信公众号:wwwtangshuangnet】 【本文首发于唐霜的博客】著作权归作者所有,禁止商业用途转载。【本文首发于唐霜的博客】本文版权归作者所有,未经授权不得转载。

- 缓存(下一节讲)【本文首发于唐霜的博客】 原创内容,盗版必究。【转载请注明来源】【版权所有,侵权必究】本文版权归作者所有,未经授权不得转载。

- HTTP2(下下下节讲)【原创不易,请尊重版权】 未经授权,禁止复制转载。本文作者:唐霜,转载请注明出处。【版权所有】唐霜 www.tangshuang.net转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。

当然,实际上,这些网络层面的优化,其实前本文作者:唐霜,转载请注明出处。原创内容,盗版必究。提是访问者的宽带。假如别人是100G光纤本文作者:唐霜,转载请注明出处。【版权所有,侵权必究】,和另一个是256k的电话线,那能一样嘛本文版权归作者所有,未经授权不得转载。【作者:唐霜】。

【原创内容,转载请注明出处】【原创内容,转载请注明出处】【关注微信公众号:wwwtangshuangnet】HTTP缓存【版权所有,侵权必究】

【作者:唐霜】【未经授权禁止转载】【转载请注明来源】在前面提到的文章一样,HTTP缓存有三种著作权归作者所有,禁止商业用途转载。原创内容,盗版必究。模式。

【版权所有】唐霜 www.tangshuang.net【本文首发于唐霜的博客】【版权所有,侵权必究】【访问 www.tangshuang.net 获取更多精彩内容】【关注微信公众号:wwwtangshuangnet】- Cache-Control + Expi【版权所有,侵权必究】【原创不易,请尊重版权】res 【版权所有】唐霜 www.tangshuang.net原创内容,盗版必究。著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。

- 304 + Last-Modified本文作者:唐霜,转载请注明出处。 本文版权归作者所有,未经授权不得转载。转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。【转载请注明来源】

- 304 + Etag【版权所有】唐霜 www.tangshuang.net 【访问 www.tangshuang.net 获取更多精彩内容】本文版权归作者所有,未经授权不得转载。【转载请注明来源】

另外,我们还能把这三种中的两种混用在一起转载请注明出处:www.tangshuang.net【版权所有】唐霜 www.tangshuang.net,起到更可控的缓存。

本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。【版权所有】唐霜 www.tangshuang.net实现HTTP缓存也得后端来做,一种是对静【版权所有】唐霜 www.tangshuang.net转载请注明出处:www.tangshuang.net态资源,可以通过配置nginx或apac本文作者:唐霜,转载请注明出处。【版权所有,侵权必究】he配置中做到,还有一种是通过后端程序来未经授权,禁止复制转载。【原创内容,转载请注明出处】做,特别是Etag,只能通过后端程序按一转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。定算法来实现。

著作权归作者所有,禁止商业用途转载。转载请注明出处:www.tangshuang.net原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。【原创不易,请尊重版权】CDN【访问 www.tangshuang.net 获取更多精彩内容】

本文作者:唐霜,转载请注明出处。转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。前面我们讲到我们没法优化DNS,但是有些【关注微信公众号:wwwtangshuangnet】【转载请注明来源】人却可以,那就是DNS服务商。我们把域名著作权归作者所有,禁止商业用途转载。原创内容,盗版必究。托管给他们,他们就可以根据用户访问的情况【原创不易,请尊重版权】【访问 www.tangshuang.net 获取更多精彩内容】来把域名解析到不同的地方,比如你有一台服【关注微信公众号:wwwtangshuangnet】【本文首发于唐霜的博客】务器就在用户所在的城市,那么就让DNS服【原创不易,请尊重版权】本文作者:唐霜,转载请注明出处。务商(或者自建的DNS服务器)把这个用户本文作者:唐霜,转载请注明出处。本文版权归作者所有,未经授权不得转载。解析到这台服务器,那么此时建立TCP也好【原创内容,转载请注明出处】本文作者:唐霜,转载请注明出处。,网络传输也好,都会快很多。CDN就是基【版权所有】唐霜 www.tangshuang.net【本文首发于唐霜的博客】于这样的想法,把我的资源和数据存到离用户【本文首发于唐霜的博客】著作权归作者所有,禁止商业用途转载。更近的服务器上面,这样通过DNS解析,就【访问 www.tangshuang.net 获取更多精彩内容】【关注微信公众号:wwwtangshuangnet】能让用户访问离自己最近的服务,提供最近的【作者:唐霜】本文版权归作者所有,未经授权不得转载。资源,建立从数据库提供最近的数据资源。至本文作者:唐霜,转载请注明出处。本文版权归作者所有,未经授权不得转载。于数据的写,就没有办法,只能往统一的数据著作权归作者所有,禁止商业用途转载。【访问 www.tangshuang.net 获取更多精彩内容】库去写,不过我们可以在架构上进行设计,比原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。如设计多层阶梯的写逻辑,或者在主备服务器原创内容,盗版必究。原创内容,盗版必究。之间拉一条100T的超大光纤。总而言之,未经授权,禁止复制转载。未经授权,禁止复制转载。通过使用CDN服务,我们让我们的用户可以【访问 www.tangshuang.net 获取更多精彩内容】本文版权归作者所有,未经授权不得转载。更快下载应用资源和数据。

【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。本文版权归作者所有,未经授权不得转载。HTTP2【版权所有,侵权必究】

未经授权,禁止复制转载。著作权归作者所有,禁止商业用途转载。【未经授权禁止转载】【转载请注明来源】【关注微信公众号:wwwtangshuangnet】首先,http2建立在https基础上,【原创不易,请尊重版权】【本文受版权保护】所以实际上,单次连接其实性能有所损耗,但【本文受版权保护】原创内容,盗版必究。是从整体规划看,它具备更高效的传输机制,【未经授权禁止转载】【原创内容,转载请注明出处】比如它通过二进制分帧传输,没有前文所讲的转载请注明出处:www.tangshuang.net【原创内容,转载请注明出处】并行请求数量的限制,那么也就可以不再依赖【作者:唐霜】【原创内容,转载请注明出处】webpack之类的打包工具了,一次性直未经授权,禁止复制转载。著作权归作者所有,禁止商业用途转载。接下拉100个体积更小的文件,可以更快。【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。另外,以前我们有keep-alive,但【原创不易,请尊重版权】【版权所有,侵权必究】是http2更厉害,还可以实现serve【关注微信公众号:wwwtangshuangnet】转载请注明出处:www.tangshuang.netr push,牛皮了。不过http2仍然未经授权,禁止复制转载。【原创不易,请尊重版权】依赖于TCP,所以最后的性能瓶颈都在TC原创内容,盗版必究。【版权所有】唐霜 www.tangshuang.netP上去了,所以现在又在研究基于UDP的h【原创内容,转载请注明出处】【转载请注明来源】ttp3,可以把这事也解决了。

未经授权,禁止复制转载。【访问 www.tangshuang.net 获取更多精彩内容】【转载请注明来源】【原创不易,请尊重版权】著作权归作者所有,禁止商业用途转载。要支持http2,不仅后端程序层面要改造【原创不易,请尊重版权】【作者:唐霜】,nginx服务器配置也要调整。但是,跟【作者:唐霜】【版权所有】唐霜 www.tangshuang.net前端,好像没啥关系。

【原创不易,请尊重版权】本文版权归作者所有,未经授权不得转载。【转载请注明来源】WebSocket/WebRTC转载请注明出处:www.tangshuang.net

【本文受版权保护】【原创不易,请尊重版权】【版权所有,侵权必究】除了http,我们还有其他武器,它们都可【版权所有】唐霜 www.tangshuang.net【转载请注明来源】以从其他侧面解决我们使用http过程中遇著作权归作者所有,禁止商业用途转载。【访问 www.tangshuang.net 获取更多精彩内容】到的一些性能损耗的问题。WebSocke本文版权归作者所有,未经授权不得转载。原创内容,盗版必究。t可以做到服务端向客户端推送消息,建立持【本文首发于唐霜的博客】本文作者:唐霜,转载请注明出处。续性的连接,这样我们就不需要每次都通过h【转载请注明来源】未经授权,禁止复制转载。ttp去请求数据,而是可以让服务器直接推【转载请注明来源】【原创不易,请尊重版权】送给我们,省去了中间各种网络连接,而且还【版权所有,侵权必究】转载请注明出处:www.tangshuang.net能无感更新界面。WebRTC可以做到客户转载请注明出处:www.tangshuang.net【关注微信公众号:wwwtangshuangnet】端之间直接通信,比如你的应用需要在用户之未经授权,禁止复制转载。著作权归作者所有,禁止商业用途转载。间交互数据,就可以使用webrtc,不需原创内容,盗版必究。原创内容,盗版必究。要经过服务器。

【本文首发于唐霜的博客】转载请注明出处:www.tangshuang.net【原创内容,转载请注明出处】【版权所有,侵权必究】世外桃源:应用分发机制优化本文版权归作者所有,未经授权不得转载。

【未经授权禁止转载】【版权所有】唐霜 www.tangshuang.net【作者:唐霜】【原创不易,请尊重版权】转载请注明出处:www.tangshuang.net本文版权归作者所有,未经授权不得转载。【版权所有】唐霜 www.tangshuang.net【本文受版权保护】【访问 www.tangshuang.net 获取更多精彩内容】五年来,我一直寻不见仇人,只闻江湖上流传【访问 www.tangshuang.net 获取更多精彩内容】【本文受版权保护】着一伙叫“鬼窍”的团伙,很可能便是当年屠【原创不易,请尊重版权】未经授权,禁止复制转载。村的罪魁祸首。游历至一镇,名叫石瀑镇,此【本文首发于唐霜的博客】【本文首发于唐霜的博客】镇飞斜于一大河瀑布旁,镇一边便是落下瀑布【访问 www.tangshuang.net 获取更多精彩内容】【原创不易,请尊重版权】的翻滚河水,另一边是大河分流出来的十来条【转载请注明来源】【作者:唐霜】支流浅滩,镇里房屋错落紧致,巷子仅可二人【关注微信公众号:wwwtangshuangnet】本文作者:唐霜,转载请注明出处。并走,瀑布声如洪钟,日复一日未曾停歇,镇【版权所有,侵权必究】【访问 www.tangshuang.net 获取更多精彩内容】上之人笑饮茶,玩闹逐,把这瀑布的轰鸣做了【本文受版权保护】本文作者:唐霜,转载请注明出处。生活的背景。镇内落差又大,最高一处便是瀑【本文首发于唐霜的博客】本文版权归作者所有,未经授权不得转载。布一侧的花石悬崖,最低一处就是浅滩。我在【版权所有,侵权必究】【原创内容,转载请注明出处】此住留半月之久,甚觉世外桃源般无拘无束,未经授权,禁止复制转载。【作者:唐霜】唯独这落差叫人吃劲,每每从浅滩客栈去到悬【转载请注明来源】【作者:唐霜】崖旁的钟寺,都让人累如魂飞,却见那些小孩转载请注明出处:www.tangshuang.net【关注微信公众号:wwwtangshuangnet】嬉闹来回不见累,果是一方人情一方水土。

【版权所有,侵权必究】本文版权归作者所有,未经授权不得转载。【关注微信公众号:wwwtangshuangnet】【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。

通过对应用架构的重新设计,我们可以从分发【转载请注明来源】【原创不易,请尊重版权】机制的角度去优化应用的加载速度,提升其打【关注微信公众号:wwwtangshuangnet】未经授权,禁止复制转载。开的速率,从而提高用户体验。什么事应用分原创内容,盗版必究。【版权所有,侵权必究】发呢?就是客户端以何种形式启动应用,基于著作权归作者所有,禁止商业用途转载。【关注微信公众号:wwwtangshuangnet】这种形式,需要我们怎么安排代码的部署、下【本文受版权保护】未经授权,禁止复制转载。载和调用。

【转载请注明来源】【访问 www.tangshuang.net 获取更多精彩内容】著作权归作者所有,禁止商业用途转载。【本文受版权保护】PWA【转载请注明来源】

本文作者:唐霜,转载请注明出处。【原创不易,请尊重版权】本文作者:唐霜,转载请注明出处。【作者:唐霜】未经授权,禁止复制转载。渐进式web应用(Progressive转载请注明出处:www.tangshuang.net转载请注明出处:www.tangshuang.net Web Apps)是一套技术的集合,而【作者:唐霜】未经授权,禁止复制转载。不是指单一技术。简单讲,PWA通过各类缓著作权归作者所有,禁止商业用途转载。【本文首发于唐霜的博客】存机制和控制机制,将应用加载时需要的资源本文作者:唐霜,转载请注明出处。【转载请注明来源】缓存在本地,从而让下一次加载该资源直接从【转载请注明来源】【版权所有】唐霜 www.tangshuang.net本地加载,进而提升性能。除了性能,它还提转载请注明出处:www.tangshuang.net本文作者:唐霜,转载请注明出处。供窗口优化、通知推送等其他方面的能力,提著作权归作者所有,禁止商业用途转载。【版权所有】唐霜 www.tangshuang.net升用户体验。不过就我个人而言,并不看好P本文版权归作者所有,未经授权不得转载。转载请注明出处:www.tangshuang.netWA,因为我们大部分应用都是需要从服务端【未经授权禁止转载】【版权所有,侵权必究】拉取数据才能使用的,而且PWA并没有提供本文作者:唐霜,转载请注明出处。【本文首发于唐霜的博客】超出浏览器能力的功能,比如读取本地文件系本文作者:唐霜,转载请注明出处。转载请注明出处:www.tangshuang.net统的能力等等,所以在国内我很少见到专门的【作者:唐霜】【未经授权禁止转载】PWA应用,不过也有不少应用使用了PWA转载请注明出处:www.tangshuang.net【原创内容,转载请注明出处】部分能力,来提升应用的加载性能。性能方面【原创不易,请尊重版权】【本文首发于唐霜的博客】主要涉及ServiceWorker的内容【作者:唐霜】【访问 www.tangshuang.net 获取更多精彩内容】。

【原创不易,请尊重版权】【原创不易,请尊重版权】本文版权归作者所有,未经授权不得转载。本文版权归作者所有,未经授权不得转载。ServiceWorker本文作者:唐霜,转载请注明出处。

本文作者:唐霜,转载请注明出处。【版权所有】唐霜 www.tangshuang.net【作者:唐霜】转载请注明出处:www.tangshuang.netServiceWorker是一种特殊的W【原创不易,请尊重版权】【转载请注明来源】ebWorker,从线程工作的模式看,和【未经授权禁止转载】【关注微信公众号:wwwtangshuangnet】WebWorker是一致的,但是不同的地【版权所有】唐霜 www.tangshuang.net【本文首发于唐霜的博客】方在于,它是全局只会有一条Service【关注微信公众号:wwwtangshuangnet】本文版权归作者所有,未经授权不得转载。Worker线程,而且ServiceWo本文版权归作者所有,未经授权不得转载。未经授权,禁止复制转载。rker中提供了比普通webworker原创内容,盗版必究。原创内容,盗版必究。更多的接口,以实现特殊的能力。其中一项重【本文受版权保护】本文作者:唐霜,转载请注明出处。要的能力,就是缓存资源。

原创内容,盗版必究。【本文受版权保护】原创内容,盗版必究。在serviceworker中,提供了c【作者:唐霜】【本文受版权保护】aches接口,通过该接口可以实现缓存的【未经授权禁止转载】【本文受版权保护】读取、写入、删除。再利用servicew【版权所有】唐霜 www.tangshuang.net【本文受版权保护】orker中拦截请求的能力,当当前应用去【关注微信公众号:wwwtangshuangnet】著作权归作者所有,禁止商业用途转载。请求某一个资源时,会被servicewo本文版权归作者所有,未经授权不得转载。【访问 www.tangshuang.net 获取更多精彩内容】rker拦截,我们可以在worker脚本【作者:唐霜】未经授权,禁止复制转载。中监听fetch事件,通过缓存的判断,直本文作者:唐霜,转载请注明出处。【版权所有,侵权必究】接respondWith缓存内容,而不需【作者:唐霜】本文版权归作者所有,未经授权不得转载。要再往服务器发送请求拉取资源。

本文作者:唐霜,转载请注明出处。本文作者:唐霜,转载请注明出处。本文作者:唐霜,转载请注明出处。原创内容,盗版必究。著作权归作者所有,禁止商业用途转载。不过ServiceWorker有一点,即原创内容,盗版必究。【版权所有】唐霜 www.tangshuang.net它需要一个注册的过程,也就是用户第一次打【版权所有,侵权必究】【版权所有】唐霜 www.tangshuang.net开应用的时候,我们只能做到注册,而注册之【本文首发于唐霜的博客】【版权所有】唐霜 www.tangshuang.net后serviceworker内的逻辑并不本文作者:唐霜,转载请注明出处。【关注微信公众号:wwwtangshuangnet】能马上生效,只有我们重新打开应用(或刷新【未经授权禁止转载】【版权所有】唐霜 www.tangshuang.net浏览器)后,才能享受其提供的服务。

【本文受版权保护】【转载请注明来源】未经授权,禁止复制转载。利用serviceworker,我们还能【本文受版权保护】【转载请注明来源】做很多事情,它不单单可以缓存,还可以实现本文版权归作者所有,未经授权不得转载。【本文首发于唐霜的博客】常驻后台拉取,这样的话,我们就可以在后台著作权归作者所有,禁止商业用途转载。原创内容,盗版必究。自己去更新一些资源,或者提取拉取一些资源原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。,从而做到让用户在无感的情况下,获得应用【版权所有】唐霜 www.tangshuang.net【本文受版权保护】的加速。

原创内容,盗版必究。【关注微信公众号:wwwtangshuangnet】著作权归作者所有,禁止商业用途转载。Workbox【本文受版权保护】

著作权归作者所有,禁止商业用途转载。【作者:唐霜】本文版权归作者所有,未经授权不得转载。原创内容,盗版必究。【关注微信公众号:wwwtangshuangnet】Workbox是谷歌基于自己的场景封装的【原创内容,转载请注明出处】【作者:唐霜】ServiceWorker库,它提供了我本文作者:唐霜,转载请注明出处。原创内容,盗版必究。们常见的一些场景下,快速实现servic【原创不易,请尊重版权】【版权所有,侵权必究】eworker中某些能力的方法,就像jq本文作者:唐霜,转载请注明出处。未经授权,禁止复制转载。uery精简了DOM的操作一样,work【原创内容,转载请注明出处】【本文受版权保护】box也是精简了我们使用servicew【本文首发于唐霜的博客】【转载请注明来源】orker的操作。

【访问 www.tangshuang.net 获取更多精彩内容】【访问 www.tangshuang.net 获取更多精彩内容】【版权所有,侵权必究】未经授权,禁止复制转载。本文作者:唐霜,转载请注明出处。微前端未经授权,禁止复制转载。

原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。本文作者:唐霜,转载请注明出处。这两年微前端度过了巅峰,今年开始微前端就未经授权,禁止复制转载。【版权所有】唐霜 www.tangshuang.net不那么热了。但是,微前端到底是怎么回事呢【本文首发于唐霜的博客】【作者:唐霜】?对于刚接触的同学,我还是有必要简单介绍【访问 www.tangshuang.net 获取更多精彩内容】【未经授权禁止转载】一下。1年多以前,我撰写了自己的微前端框未经授权,禁止复制转载。【作者:唐霜】架mfy(麦饭)【关注微信公众号:wwwtangshuangnet】,提供了一种独特、酷炫、简易的微前端框架【版权所有,侵权必究】【关注微信公众号:wwwtangshuangnet】。基于已有的经验,我来讲讲自己的一些建议转载请注明出处:www.tangshuang.net【本文首发于唐霜的博客】。

未经授权,禁止复制转载。著作权归作者所有,禁止商业用途转载。【版权所有】唐霜 www.tangshuang.net本文作者:唐霜,转载请注明出处。通过微前端,我们可以做到类似按需加载的效【未经授权禁止转载】转载请注明出处:www.tangshuang.net果,从而提升应用的加载性能。微前端由基座【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。应用和子应用构成,应用打开时,需要首先加【版权所有】唐霜 www.tangshuang.net原创内容,盗版必究。载基座应用,当然,我们会同时并行的根据路本文版权归作者所有,未经授权不得转载。本文版权归作者所有,未经授权不得转载。由去加载对应的子应用。不同的应用同屏的子转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。应用数量不同,如果一屏只有一个子应用,那【版权所有,侵权必究】【关注微信公众号:wwwtangshuangnet】么只有当切换路由,需要加载另外一个子应用【原创不易,请尊重版权】未经授权,禁止复制转载。时,才会去加载新的代码。当然,我们也可以本文作者:唐霜,转载请注明出处。【原创内容,转载请注明出处】做一些预加载的工作。

转载请注明出处:www.tangshuang.net本文版权归作者所有,未经授权不得转载。转载请注明出处:www.tangshuang.net【版权所有】唐霜 www.tangshuang.net不同的微前端框架实现模式不同,知名框架q【转载请注明来源】【版权所有,侵权必究】iankun基于沙箱模式加载子应用,实际【版权所有,侵权必究】未经授权,禁止复制转载。上会严重降低子应用运行时的性能,并不适合本文版权归作者所有,未经授权不得转载。【版权所有,侵权必究】需要大规模计算和交互的应用,只适合一些不本文作者:唐霜,转载请注明出处。本文版权归作者所有,未经授权不得转载。复杂交互不频繁的应用。但是另外还有一些微转载请注明出处:www.tangshuang.net【版权所有】唐霜 www.tangshuang.net前端架构,并不依赖沙箱,不过一般会统一技【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。术栈,比如基于angular或react原创内容,盗版必究。本文作者:唐霜,转载请注明出处。的微前端框架,就要求子应用必须是对应技术转载请注明出处:www.tangshuang.net本文作者:唐霜,转载请注明出处。栈的,但是这类微前端框架的运行性能就好很【作者:唐霜】本文版权归作者所有,未经授权不得转载。多,和普通的单体应用差别不大,所以也可以原创内容,盗版必究。转载请注明出处:www.tangshuang.net用来运行有计算,且交互复杂的应用。

【原创不易,请尊重版权】本文作者:唐霜,转载请注明出处。【本文受版权保护】微前端作为前端的一种架构方式,已经改变了【原创不易,请尊重版权】【作者:唐霜】前端项目代码组织的方式。在前端性能方面,未经授权,禁止复制转载。【版权所有】唐霜 www.tangshuang.net基于微前端架构,以及强制性做到了按需加载【转载请注明来源】本文版权归作者所有,未经授权不得转载。,子应用分包。对于前端项目而言,很多项目【作者:唐霜】【作者:唐霜】到最后都会考虑采用微前端架构,但是由于架【本文首发于唐霜的博客】【访问 www.tangshuang.net 获取更多精彩内容】构变化带来的破坏性非常大,所以一些已经持【版权所有,侵权必究】【未经授权禁止转载】续了几年的巨无霸应用想转微前端,就异常艰【原创内容,转载请注明出处】【作者:唐霜】难。所以,我建议当一个项目运行了1年左右原创内容,盗版必究。【关注微信公众号:wwwtangshuangnet】,负责人发现未来该项目还会持续迭代时,就原创内容,盗版必究。【本文首发于唐霜的博客】应该赶紧考虑采用微前端架构进行重构。这样【访问 www.tangshuang.net 获取更多精彩内容】【本文受版权保护】就可以避免应用打包变大后加载更慢,也可以【关注微信公众号:wwwtangshuangnet】【关注微信公众号:wwwtangshuangnet】将庞大的应用分开治理,从而做到更优秀的代未经授权,禁止复制转载。本文作者:唐霜,转载请注明出处。码治理。

【原创不易,请尊重版权】【未经授权禁止转载】未经授权,禁止复制转载。小程序【访问 www.tangshuang.net 获取更多精彩内容】

本文作者:唐霜,转载请注明出处。【原创不易,请尊重版权】本文版权归作者所有,未经授权不得转载。未经授权,禁止复制转载。小程序是微信的创新,我觉得它是PWA+微【版权所有】唐霜 www.tangshuang.net未经授权,禁止复制转载。前端的强强组合。首先,它在微信这个大应用转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。下,基于类似微前端的架构模式,按需的拉取本文版权归作者所有,未经授权不得转载。【访问 www.tangshuang.net 获取更多精彩内容】单个小程序的代码,实时的渲染,从而降低整【转载请注明来源】原创内容,盗版必究。个应用的代码储量和内存占用,让一个微信拥【本文受版权保护】【作者:唐霜】有无限可能。其次,它的每一个应用就类似P【本文受版权保护】未经授权,禁止复制转载。WA一样,有自己的独立空间,而且每次运行【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。只能运行一个小程序,代码被按照版本缓存在【关注微信公众号:wwwtangshuangnet】【原创内容,转载请注明出处】本地(定期清理),从而在第二次打开的时候【作者:唐霜】未经授权,禁止复制转载。做到秒开。